Introduction

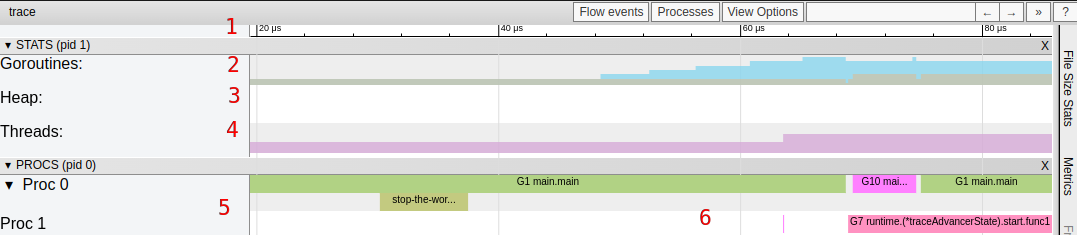

Rust

资料

0. book

- Rust book 官方教程

- Rust 死灵书 官方Rust死灵书,主要是如何何撰写和使用 unsafe Rust

- Rust标准库 标准库

- Rustlings 小练习, 用来夯实对知识和概念的理解

- This week in Rust

- Rust 语言开源杂志 每月一期, 囊括了大量优秀的 Rust 文章

- Beginner’s Series to: Rust 微软推出的一系列Rust培训

- Comprehensive Rust google 出品

- The Rustonomicon unsafe rust

- Jon Gjengset 大佬youtube, 他的视频面向中高级 Rust 用户, 适合学习完本课程后再去观看

- cheat rs Rust Language Cheat Sheet

- Rust for Rustaceans Rust for Rustaceans

- Rust Atomics and Locks

1. 工具

-

代码安全

- cargo-tarpaulin 代码覆盖率

- clippy 代码检查

- cargo-audit

Cargo.lock安全审核 - cargo-flamegraph 在跟踪代码中的性能热点时给了我们巨大的帮助.

- cargo-geiger 帮助我们快速评估外部依赖, 以解决可能的安全性 (或正确性) 问题.

- cargo tree (最近集成进了 cargo) 显示了一个依赖树, 它在许多方面都很有用, 但主要用于找出最小化依赖项的途径

- cargo-udeps 可以识别未使用的依赖项, 并尽可能减少我们的构建时间

- cargo-deny 检查依赖

-

调试工具

-

编译

- cargo-watch 即时编译

- sccache sccache is ccache with cloud storage, Shared Compilation Cache

-

平台编译打包

- cross 零设置的跨平台 交叉编译和交叉测试

- cargo-deb 打包成.deb

- cargo-generate-rpm 打包成rpm

- cargo-aur 打包成 Arch Linux User Repository

2. crate

mini-sized-rustHow to minimize Rust binary sizepassword-hashedPassword hashing functions / KDFstracingApplication level tracing for Rust.pestThe Elegant ParsernomRust parser combinator frameworkpolarsFast multi-threaded, hybrid-streaming DataFrame library in Rust | Python | Node.jsr2d2A generic connection pool for Rust

3. 建议

3.1 密码建议

- 如果

Argon2id可用, 那么使用Argon2id(需要目标机器至少有 15MB 内存) . - 如果

Argon2id不可用, 那么使用bcrypt(算法至少迭代 10 次) . - 最后再考虑

scrypt/PBKDF2.

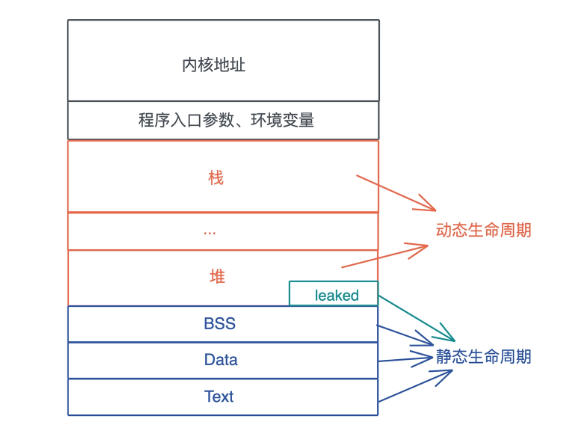

内存模型

类型的布局是其大小 (size) 、对齐方式 (align) 及其字段的相对偏移量. 对于枚举, 如何布局和解释判别式也是类型布局的一部分. 对于 Sized 的数据类型, 可以在编译时知道内存布局, 可以通过 size_of 和 align_of 获得其 size 和 align.

The layout of a type is its size, alignment, and the relative offsets of its fields.

For enums, how the discriminant is laid out and interpreted is also part of type layout.

Type layout can be changed with each compilation.

Note: 本文内存模型不考虑优化,是广文上的模型,实际中 Rust会对一些数据类型做优化.

1. 整型

| Type | size(bytes) | align(bytes) |

|---|---|---|

u8 | 1 | 1 |

i8 | 1 | 1 |

u16 | 2 | 2 |

i16 | 2 | 2 |

u32 | 4 | 4 |

i32 | 4 | 4 |

i64 | 8 | 8 |

u64 | 8 | 8 |

i128 | 16 | 16 |

u128 | 16 | 16 |

2. 浮点型

The IEEE 754-2008 "binary32" and "binary64" floating-point types are f32 and f64, respectively.

| Type | size(bytes) | align(bytes) |

|---|---|---|

f32 | 4 | 4 |

f64 | 8 | 8 |

3. usized & isized

| Type | size(bytes)/ 32位系统 | size(bytes)/ 64位系统 |

|---|---|---|

usize | 4 | 8 |

isize | 4 | 8 |

4. str

4.1 char 类型

char表示:一个 32 位(4 Bytes)长度字符, Unicode 标量值 Unicode Scalar Value 范围为 0x0000 - 0xD7FF 或者是 0xE000 - 0x10FFFF.

4.2 str 类型

str 与 [u8] 一样表示一个 u8 的 slice. Rust 中标准库中对 str 有个假设:符合 UTF-8 编码. 内存布局与 [u8] 相同.

5. & 和&[T] 引用

5.1 &

#![allow(unused)] fn main() { let a: i32 = 25; let b: &i32 = &a; let c: &&i32 = &b; stack | a | | b | │ c │ +––––+––––+––––+––––+––––+ │ 25 │ │ * │ │ * │ +––^–+––––+–│^–+––––+–│––+ │ │|________| │________│ }

5.2 &[T] slice 引用

slice 的使用必须要通过指针, &[T] 是一个胖指针, 保存指向数据的地址和元素个数. slice 的内存布局与其指向的 array 部分相同.

#![allow(unused)] fn main() { // array &[T] let a:[i32;3] = [55,66,77]; let b:&[i32] = &a[..2] stack [–––– a ––––| |––– b ––| +––––+––––+––––+–––+––––+––––+ │ 55 │ 66 │ 77 │ | * | 2 | +––––+––––+––––+–––+––––+––––+ | | / / –––––––––––<––––––––/ / / length buffer point }

#![allow(unused)] fn main() { // Vec<T> &[T] let a:Vec<i32> = vec![55,66,77]; let b:&[i32] = &a[..2] stack [––– a ––| |––– b ––| +–––+–––+–––+ +––––+––––+ │ • │ 3 │ 4 │ | * | 2 | +–│–+–––+–––+ +–│––+––––+ │ │ heap │ │ +–V––+––––+––––+ │ │ 55 │ 66 │ 77 │ │ +––––+––––+––––+ │ | │ │ –––––––––––<––––––––/ }

6. &str,str 和 String 的区别

6.1 String

#![allow(unused)] fn main() { String: let s: String = String::from("hello"); buffer point / capacity / / length stack / / / +–––+–––+–––+ │ • │ 8 │ 5 │ +–│–+–––+–––+ │ heap │ +–V–+–––+–––+–––+–––+–––+–––+–––+ │ h │ e │ l │ l │ o │ │ │ │ +–––+–––+–––+–––+–––+–––+–––+–––+ [––––––– length ––––] [–-–––––––– capacity –––––––––––] }

6.2 str和&str

#![allow(unused)] fn main() { &str: let s: &str = "hello"; buffer point / length stack / / +–––+–––+ │ • │ 5 │ &str +–│–+–––+ │ read-only │ memory │ [–│–––––– str ––––––] +–V–+–––+–––+–––+–––+ │ h │ e │ l │ l │ o │ +–––+–––+–––+–––+–––+ }

7. tuple

#![allow(unused)] fn main() { let a: (char, u8, i32) = ('a', 7, 356) stack [–––––––––––––– 12 Bytes –––––––––––––––––––| +–––––––––––––+–––––+–––––––––+–––––––––––––+ │ 'a' │ 7 │ padding │ 356 │ +–––––––––––––+–––––+–––––––––+–––––––––––––+ |–– 4 Bytes ––| 4 Bytes |–– 4 Bytes ––| }

8. struct

结构体是带命名的复合类型, rust有三种结构体类型: struct, StructExprStruct,StructExprUnit

8.1 struct 含有字段的结构体

#![allow(unused)] fn main() { struct Data { nums: Vec<u8>, a: u8, } stack [––– nums ––|– a –] +–––+–––+–––+–––––+ │ • │ 8 │ 5 │ 10 | +–│–+–––+–––+–––––+ │ heap │ +–V–+–––+–––+–––+–––+–––+–––+–––+ │ 0 │ 0 │ 0 │ 0 │ 0 │ │ │ │ +–––+–––+–––+–––+–––+–––+–––+–––+ }

8.2 StructExprTuple 元组结构体

#![allow(unused)] fn main() { struct Data(i32, i32, i32); stack [––– Data ––| +–––+–––+–––+ │ 1 │ 2 │ 3 │ +–––+–––+–––+ }

8.3 StructExprUnit 单元结构体

单元结构体没有任何数据,所以Rust编译器甚至不会为它分配任何内存.

#![allow(unused)] fn main() { struct Data; }

9. enum

9.1 C风格枚举

#![allow(unused)] fn main() { // 占一个字节 enum HTTPStatus { Ok; NotFound, } HTTPStatus::Ok stack +–––+ │ 0 │ +–––+ HTTPStatus::NotFound stack +–––+ │ 1 │ +–––+ }

9.2 C风格指定值枚举

#![allow(unused)] fn main() { // 占两个字节 enum HTTPStatus { Ok = 200; NotFound = 404, } HTTPStatus::Ok stack +–––––+ │ 200 │ +–––––+ HTTPStatus::NotFound stack +–––––+ │ 404 │ +–––––+ }

9.3 变体枚举

#![allow(unused)] fn main() { enum Data { Empty; Number(i32), Array(Vec<i32>), } stack Data::Empty +–––––+––––––––––––––––––––––––––––––––––––––––––––––+ │ 0 │ padding │ +–––––+––––––––––––––––––––––––––––––––––––––––––––––+ | mark| Data::Number +–––––+–––––––––+–––––––––––+––––––––––––––––––––––––+ │ 1 │ padding │ 0 │ padding │ +–––––+–––––––––+–––––––––––+––––––––––––––––––––––––+ | mark| |–– i32 –––| |–– value ––| Data::Array(Vec<i32>) [––––––––––––––––––––– 32 Bytes –––––––––––––––––––––| +–––––+–––––––––+–––––––––––+––––––––––––+–––––––––––+ │ 2 │ padding │ none │ 0 │ 0 │ +–––––+–––––––––+–––––––––––+––––––––––––+–––––––––––+ | mark| |––––––––––––– Vec<i32> ––––––––––––| |– pointer –|– capacity –|– length –| –––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––––– enum Data { Empty; Number(i32), Array(Box<Vec<i32>>), } stack Data::Empty +–––––+–––––––––––––––––––––+ │ 0 │ padding │ +–––––+–––––––––––––––––––––+ | mark| Data::Number +–––––+–––––––––+–––––––––––+ │ 1 │ padding │ 0 │ +–––––+–––––––––+–––––––––––+ | mark| |–– i32 –––| |–– value ––| Data::Array(Vec<i32>) [––––––– 16 Bytes ––––––––––| +–––––+–––––––––+–––––––––––+ │ 2 │ padding │ * │ +–––––+–––––––––+––│––––––––+ | mark| |– │ Box<T>–| |– │ pointer| │ heap V +–––––––––––+––––––––––––+–––––––––––+ │ none │ 0 │ 0 │ +–––––––––––+––––––––––––+–––––––––––+ }

9.4 Option<T>

#![allow(unused)] fn main() { Option<Box<i32>> None +–––––+–––––––––––––––––––––+ │ 0 │ padding │ +–––––+–––––––––––––––––––––+ | mark| Some(Box<i32>) +–––––+–––––––––+–––––––––––+ │ 1 │ padding │ * │ +–––––+–––––––––+–––––––––––+ +–––––+–––––––––+––│––––––––+ | mark| |– │ Box<T>–| |– │ pointer| │ heap V +–––––––––––+ │ 0 │ +–––––––––––+ // 因为智能指针的值都不允许为0, 所以实际上上面会进行优化成下面的方式 None +–––––––––––+ │ 0 │ +–––––––––––+ | mark| Some(Box<i32>) +–––––––––––+ │ * │ +–––––––––––+ +––│––––––––+ |– │ Box<T>–| |– │ pointer| │ heap V +–––––––––––+ │ 0 │ +–––––––––––+ }

10. array,[T]和Vec<T>

10.1 array

#![allow(unused)] fn main() { let a:[i32;3] = [55,66,77]; stack [–––– a ––––| +––––+––––+––––+ │ 55 │ 66 │ 77 │ +––––+––––+––––+ }

10.2 [T]

[T]即slice 是DST 类型, 是类型 T 序列的一种视图. 所以它只能使用&[T]宽指针进行引用,参考[&[T] 引用](# 5. & 和&[T] 引用)

10.3 Vec<T>

#![allow(unused)] fn main() { let a:Vec<i32> = vec![55,66,77]; stack [––– a ––| +–––+–––+–––+ │ • │ 3 │ 4 │ +–│–+–––+–––+ │ heap │ +–V––+––––+––––+ │ 55 │ 66 │ 77 │ +––––+––––+––––+ }

11. 智能指针

11.1 Box<T>

Box<T>单所有权,只适用于单线程

#![allow(unused)] fn main() { let v: Box<Vec<i32>> = Box::new(vec![55,66,77]); stack [ v ] +–––+ │ * │ +–│–+ | heap | +–V–+–––+–––+ │ * │ 3 │ 3 │ +–│–+–––+–––+ │ │ +–V––+––––+––––+ │ 55 │ 66 │ 77 | +––––+––––+––––+ }

11.2 Rc<T>

Rc<T> 多所有权,只适用于单线程,且只可用于不可变借用.

#![allow(unused)] fn main() { let v: Rc<Vec<i32>> = Rc::new(vec![55,66,77]); let v2 = v.clone() stack [ v ] [ v2 ] +–––+ +–––+ │ * │ * │ +–│–+ +–│–+ |___________| heap | +–V–+–––+–––+–––+ │ 2 │ * │ 3 │ 3 | +–––+–│–+–––+–––+ / │ ref count<– / │ +–V––+––––+––––+ │ 55 │ 66 │ 77 | +––––+––––+––––+ }

11.3 Arc<T>

Arc<T> 数据模型同Rc<T>但可使用于多线程, 多所有权,只可用于不可变借用.

Arc<T> 与Rc<T>区别在于,引用计数是原子计数

#![allow(unused)] fn main() { stack [ptr |meta] +–––-+–––+ │ * │ │ +–│-–+--–│ | heap | +–V–+–––+–––+ │ │ │ T │ +–––+--–+–––+ / │ ref count <–/ V weak ref count }

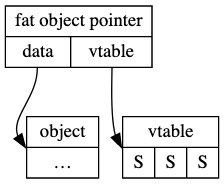

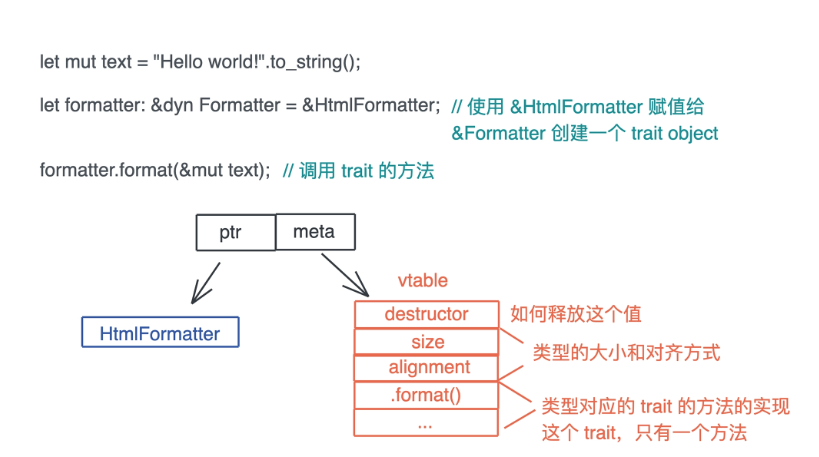

12. trait object

官方定义:

A trait object is an opaque value of another type that implements a set of traits.

The set of traits is made up of an object safe base trait plus any number of auto traits.

trait 是 DST 类型 ,对trait的引用称之为 trait object, trait object是个胖指针, 包含两个普通指针分别为 data和 vtable.

13. Dynamically Sized Types(DST) 动态类型

一般来说大多数类型, 可以在编译阶段确定大小和对齐属性, Sized trait 就是保证了这种特性.

非 size (?Sized) 及 DST 类型.

- DST 类型有 slice 和 trait object.

- DST 类型必须通过指针来使用,需要注意:

- DST 可以作为泛型参数, 但是需要注意泛型参数默认是

Sized, 如果是 DST 类型需要特别的指定为?Sized.

14. 空类型 (Empty Types)

#![allow(unused)] fn main() { enum Void {} }

空类型的一个主要应用场景是在类型层面声明不可到达性. 假如, 一个 API 一般需要返回一个 Result, 但是在特殊情况下它是绝对不会运行失败的. 这种情况下将返回值设为 Result<T, Void>, API 的调用者就可以信心十足地使用 unwrap, 因为不可能产生一个 Void 类型的值, 所以返回值不可能是一个 Err.

15. function

#![allow(unused)] fn main() { stack [ f | +–––+ │ * │ +–│–+ | machine code of function }

16. closure

闭包相当于一个捕获变量的结构体, 实现了 FnOnce 或 FnMut 或 Fn.

17. Reference

18. 生命周期

所有权机制

- 一个值只能被一个变量所拥有, 这个变量被称为所有者(Each value in Rust has a variable that’s called its owner).

- 一个值同一时刻只能有一个所有者(There can only be one owner at a time), 也就是说不能有两个变量拥有相同的值. 所以对应刚才说的变量赋值、参数传递、函数返回等行为, 旧的所有者会把值的所有权转移给新的所有者, 以便保证单一所有者的约束.

- 当所有者离开作用域, 其拥有的值被丢弃(When the owner goes out of scope, the value will be dropped), 内存得到释放.

1. Copy trait

- 原生类型, 包括函数、不可变引用和裸指针实现了 Copy;

- 数组和元组, 如果其内部的数据结构实现了 Copy, 那么它们也实现了 Copy;

- 可变引用没有实现 Copy;

- 非固定大小的数据结构, 没有实现 Copy

2. Copy语义和Move语义

是否实现 Copy Trait 区分 Copy语义和 Move 语义

Copy语义按位复制Copy语义对应值类型Move语义对应引⽤类型.

所有权机制: 保证内存安全和性能 所有权转移. 每个值都有⼀个所有者.

fn main() { // Box没有实现copy trait let a = Box::new(5); let b = a; println!("{:?}", a); // a move to b, compile error }

2.1 Struct, Enum

Struct成员均实现Copy trait, 但rust并不会默认为struct实现copy

#[derive(Debug)] struct A { // 成员虽然是copy语义, 但rust并不会默认为struct实现copy a: i32, b: i32 } // 显示指定struct实现copy trait #[derive(Debug, Copy, Clone)] struct B { a: i32, b: i32 } fn main() { let a = A{a: 1, b: 2}; let b = a; println!("{:?}", a); // a move to b, compile error }

Struct需要显式实现Copy trait,使用Copy宏.

// 显式指定struct实现copy trait #[derive(Debug, Copy, Clone)] struct A { a: i32, b: i32 } fn main() { let a = A{a: 1, b: 2}; let b = a; println!("{:?}", a); // a copy to b }

Struct成员含有未实现Copy trait, 那么Copy宏显式指定将导致编译失败

#![allow(unused)] fn main() { #[derive(Debug, Copy, Clone)] struct A { a: i32, // 当成员有未实现Copy trait的成员,即使手动指定也会编译失败 b: Box<i32> } fn main() { let a = A{a: 1, b: Box::new(5)}; let b = a; println!("{:?}", a); // a move to b, compile error } }

2.2 Tuple, Option, Array

语言默认的,成员实现则其实现Copy trait

2.2.1 Tuple

#![allow(unused)] fn main() { fn main() { let a = (String::from("a"), String::from("b")) let b = a; println!("{:?}", a); // a move to b, compile error let c = (1, 2, 3) let d = c; println!("{:?}", c); // c copy to d } }

2.2.2 Arrary

fn main() { let v = [1, 2, 3]; foo(v); // copy assert_eq!([1, 2, 3], v) } fn foo(mut v: [i32; 3]) -> [i32; 3] { v[0] = 3; assert_eq!([3, 2, 3], v); v }

fn main() { let mut v = [1, 2, 3]; foo(&mut v); // borrow assert_eq!([3, 2, 3], v) } fn foo(v: &mut [i32; 3]) { v[0] = 3; }

3. 借用规则

- 借⽤的⽣命周期不能⻓于出借⽅. --> 防⽌出现悬垂指针.

- 可变借⽤不能有别名. --> 独占, 可变借⽤不能共享, 只能独占, 只能有⼀个.

- 不可变借⽤可以多个共享. --> 共享不可变

- 不可变借用和可变借用不可同时存在(作用域内).

4. 解引用操作会获取所有权

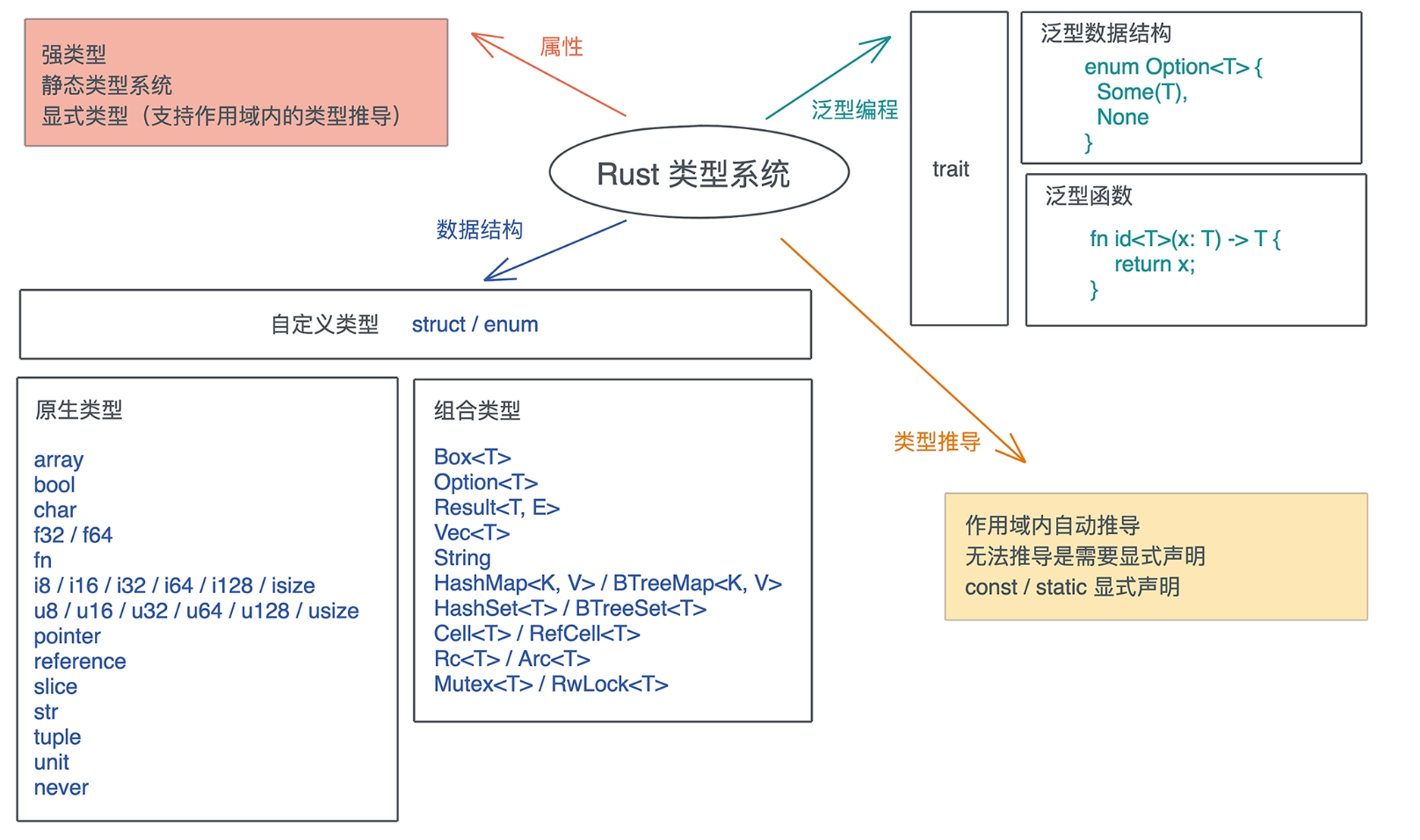

类型系统

1. 概述

- 类型大小, 类型在内存中对⻬、布局

- 类型推导

- 泛型

Trait- 类型转换

- 多态

Rust是一⻔显式静态强类型的类型安全语言

- 显式: 是因为它的类型推导在某些时候需要显示指定

- 静态: 表明它在编译期进行类型检查

- 强类型: 表明它不允许类型自动隐式转换,不同类型无法进行计算

- 类型安全: 表明它保证运行时的内存安全, 只能按照被允许的方法, 访问它被授权访问的内存

2 类型大小

2.1 可确定大小类型

use std::mem; fn main() { println!("{}", mem::size_of::<bool>()); println!("{}", mem::size_of::<u8>()); println!("{}", mem::size_of::<i8>()); println!("{}", mem::size_of::<u16>()); println!("{}", mem::size_of::<i16>()); println!("{}", mem::size_of::<u32>()); println!("{}", mem::size_of::<i32>()); println!("{}", mem::size_of::<f32>()); println!("{}", mem::size_of::<f64>()); println!("{}", mem::size_of::<char>()); println!("{}", mem::size_of::<()>()); }

2.2 动态大小类型

fn main() { let str = "hello world"; let prt = str.as_ptr(); let len = str.len(); println!("{:p}", prt); println!("{:?}", len); }

2.3 零值类型

零值类型: 类型的特别是可以提高性能或实现某些trait而不关心其数据

use std::mem; // 零大小类型, 不分配内存空间. enum Void {} // 空枚举 struct Foo; // 单元结构体 struct Bar { foo: Foo, qux: (), // 单元类型 bax: [u8; 0], // 空数组 } fn main() { println!("{}", mem::size_of::<()>()); println!("{}", mem::size_of::<Void>()); println!("{}", mem::size_of::<Foo>()); println!("{}", mem::size_of::<Bar>()); println!("{}", mem::size_of::<[(); 10]>()); }

3. 类型推导

3.1 自动推导

// Rust大部份情况下可以根据上下文明推导类型 fn main() { let a = 1; // 没有标注类型. let b = 2; // 没有标注类型. sum(a, b); // Rust 自动推导了a和b的类型. let elem = 5u8; let mut vec = Vec::new(); vec.push(elem); } fn sum(a: u32, b: i32) -> u32 { a + (b as u32) }

3.2 手动标注

// 引入 turbofish 操作符 ::<> fn main() { let x = "1"; println!("{:?}", x.parse::<u32>().unwrap()); }

4. 泛型

单态化 零成本抽象的一种实现,

其实在 Rust 里, 生命周期标注也是泛型的一部分, 一个生命周期 'a 代表任意的生命周期, 和 T 代表任意类型是一样的

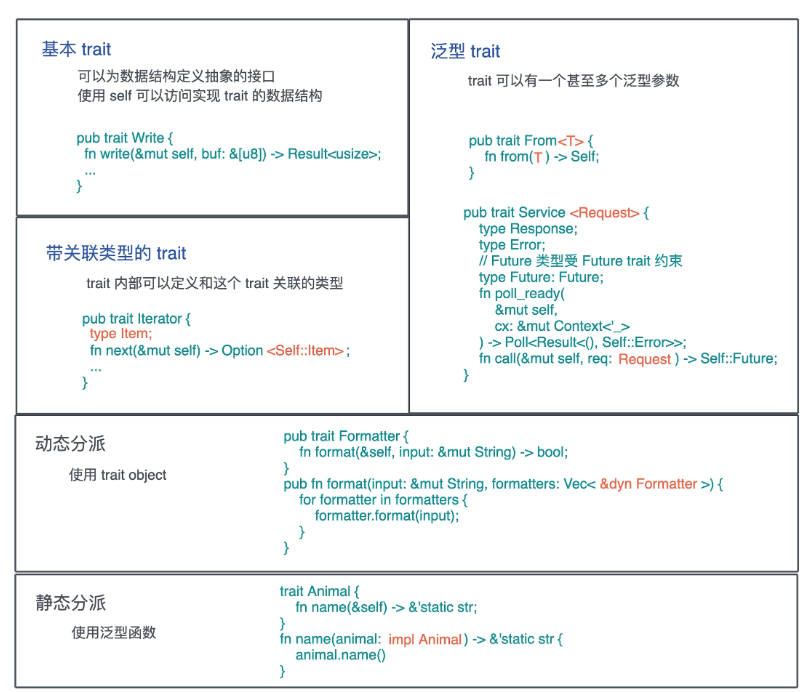

5. Trait

Rust的trait提供了零成本抽象能力, 它定义了类型使用这个接口的行为

在 trait 中, 方法可以有缺省的实现.

在定义方法的时候, 频繁看到两个特殊的关键字:Self 和 self.

Self代表当前的类型, 比如File类型实现了Write, 那么实现过程中使用到的Self就指代File.self在用作方法的第一个参数时, 实际上是self: Self的简写, 所以&self是self: &Self, 而&mut self是self: &mut Self.

trait 的"继承"

在 Rust 中, 一个 trait 可以“继承”另一个 trait 的关联类型和关联函数. 比如 trait B: A , 是说任何类型 T, 如果实现了 trait B, 它也必须实现 trait A, 换句话说, trait B 在定义时可以使用 trait A 中的关联类型和方法

Trait 如何定义和使用

Trait Object 实现原理

6. 类型转换

无歧义完全限定语法

trait A { fn test(&self, i: i32) { println!("from trait A: {:?}", i) } } trait B { fn test(&self, i: i32) { println!("from trait B: {:?}", i) } } struct S(i32); impl A for S {} impl B for S {} fn main() { let s = S(1); A::test(&s, 2); <S as A>::test(&s, 2); B::test(&s, 2); <S as B>::test(&s, 2); }

7. 多态

静态类型系统, 多态可以通过参数多态(parametric polymorphism)、特设多态(adhoc polymorphism)和子类型多态(subtype polymorphism)实现.

- 参数多态是指, 代码操作的类型是一个满足某些约束的参数, 而非具体的类型.

Rust通过泛型支持. - 特设多态是指同一种行为有多个不同实现的多态. 比如加法, 可以 1+1, 也可以是 “abc” + “cde”、matrix1 + matrix2、甚至 matrix1 + vector1. 在面向对象编程语言中, 特设多态一般指函数的重载.

Rust通过trait支持. - 子类型多态是指, 在运行时, 子类型可以被当成父类型使用.

Rust通过trait object支持.

在 Rust 中, 参数多态通过泛型来支持、特设多态通过 trait 来支持、子类型多态可以用 trait object 来支持,

7.1 参数多态

它包括泛型数据结构和泛型函数

-

泛型数据结构:

Rust对数据结构的泛型, 或者说参数化类型, 有着完整的支持. 例:Option<T> -

泛型函数: 在声明一个函数的时候, 我们还可以不指定具体的参数或返回值的类型, 而是由泛型参数来代替

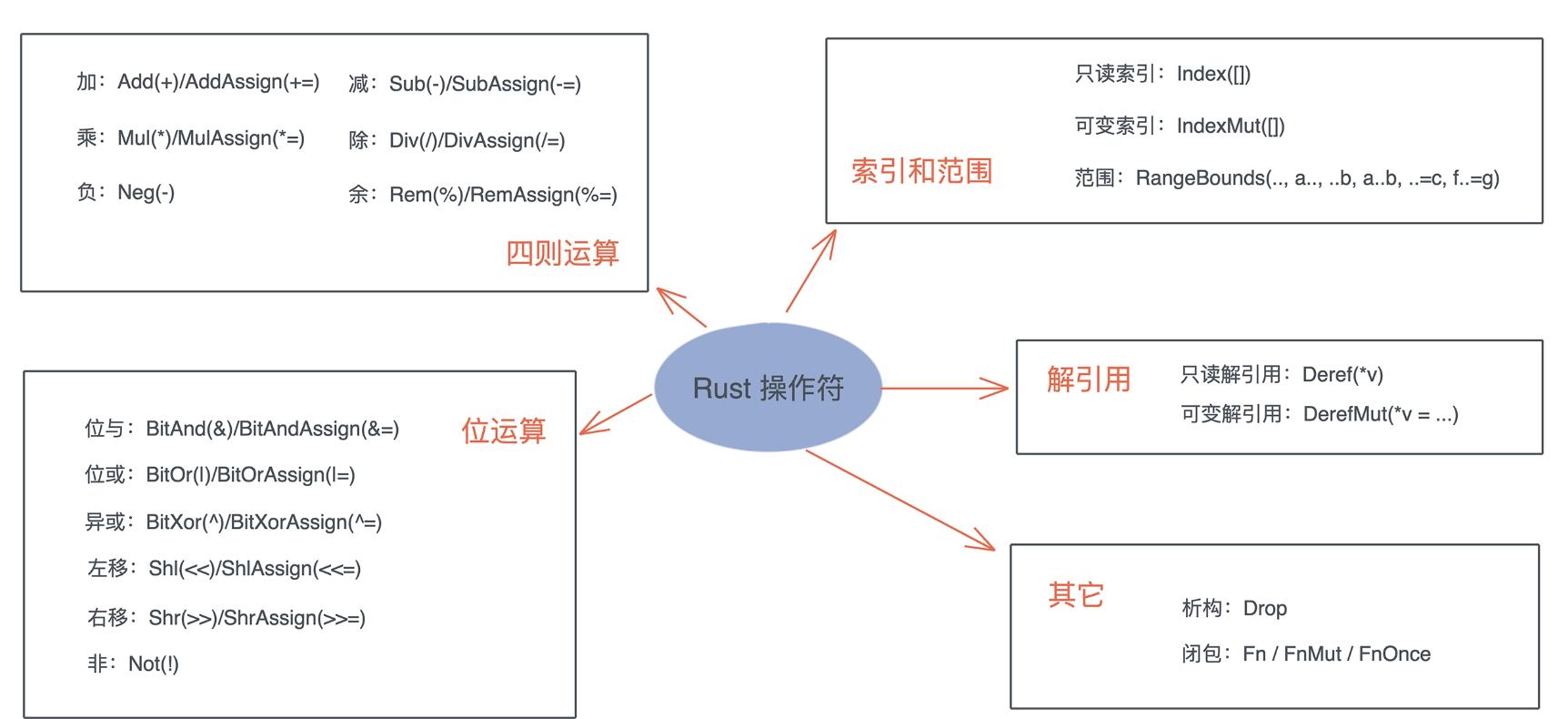

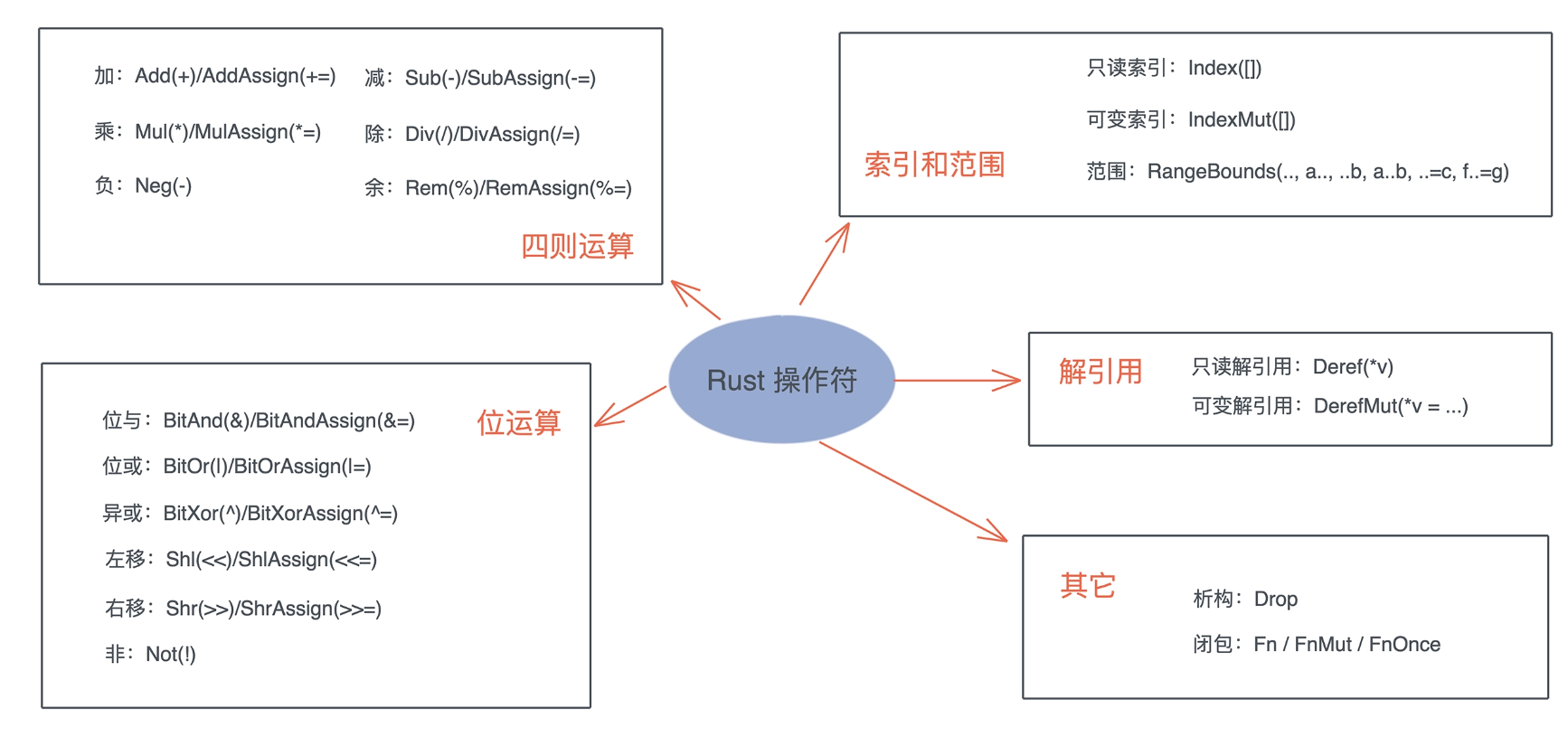

7.2 特设多态

包括运算符重载, 是指同一种行为有很多不同的实现

7.3 子类型多态

子类型当成父类型使用, 通过 trait object 来支持,

无畏并发

Concurrent: 程序的不同部分之间独立的运行, 同时处理很多事情的能力.Parallel: 程序的不同部分同时运行, 同时执行很多事情的手段.

1. Sync和Send trait

#![allow(unused)] fn main() { pub unsafe auto trait Send {} pub unsafe auto trait Sync {} }

这两个trait(std::marker::Sync和std::marker::Send)都是 unsafe auto trait, auto 意味着编译器会在合适的场合, 自动为数据结构添加它们的实现, 而 unsafe 代表实现的这个 trait 可能会违背 Rust 的内存安全准则, 如果开发者手工实现这两个 trait, 要自己为它们的安全性负责.

Send/Sync 是 Rust 并发安全的基础:

-

Send: 允许线程间转移所有权,Rc<T>没有实现Send,它只用于单线程的情景.- 任何完全由

Send类型组成的类型也被标记为Send - 除了原始指针之外,几乎所有的基础类型都是实现了

Send

- 任何完全由

-

Sync: 允许从多线程访问.- 实现了

Sync的类型可以安全的被多个线程引用 - 如果

T是Sync,那&T就是Send, 引用可以被安全的送往另一个线程.

- 实现了

-

手动来实现

Send和Sync是很难保证安全的,需要很谨慎的使用unsafe代码.-

如果一个类型

T实现了Send trait, 意味着T可以安全地从一个线程移动到另一个线程, 也就是说所有权可以在线程间移动. -

如果一个类型

T实现了Sync trait, 则意味着&T可以安全地在多个线程中共享. 一个类型T满足Sync trait, 当且仅当&T满足Send trait.

-

对于 Send/Sync 在线程安全中的作用, 可以这么看, 如果一个类型 T: Send, 那么 T 在某个线程中的独占访问是线程安全的;如果一个类型 T: Sync, 那么 T 在线程间的只读共享是安全的.

对于我们自己定义的数据结构, 如果其内部的所有域都实现了 Send / Sync, 那么这个数据结构会被自动添加 Send / Sync.

标准库中, 不支持 Send / Sync 的数据结构主要有:

- 裸指针

*const T/*mut T. 它们是不安全的, 所以既不是Send也不是Sync. UnsafeCell不支持Sync. 也就是说, 任何使用了Cell或者RefCell的数据结构不支持Sync.- 引用计数

Rc不支持Send也不支持Sync. 所以Rc无法跨线程.

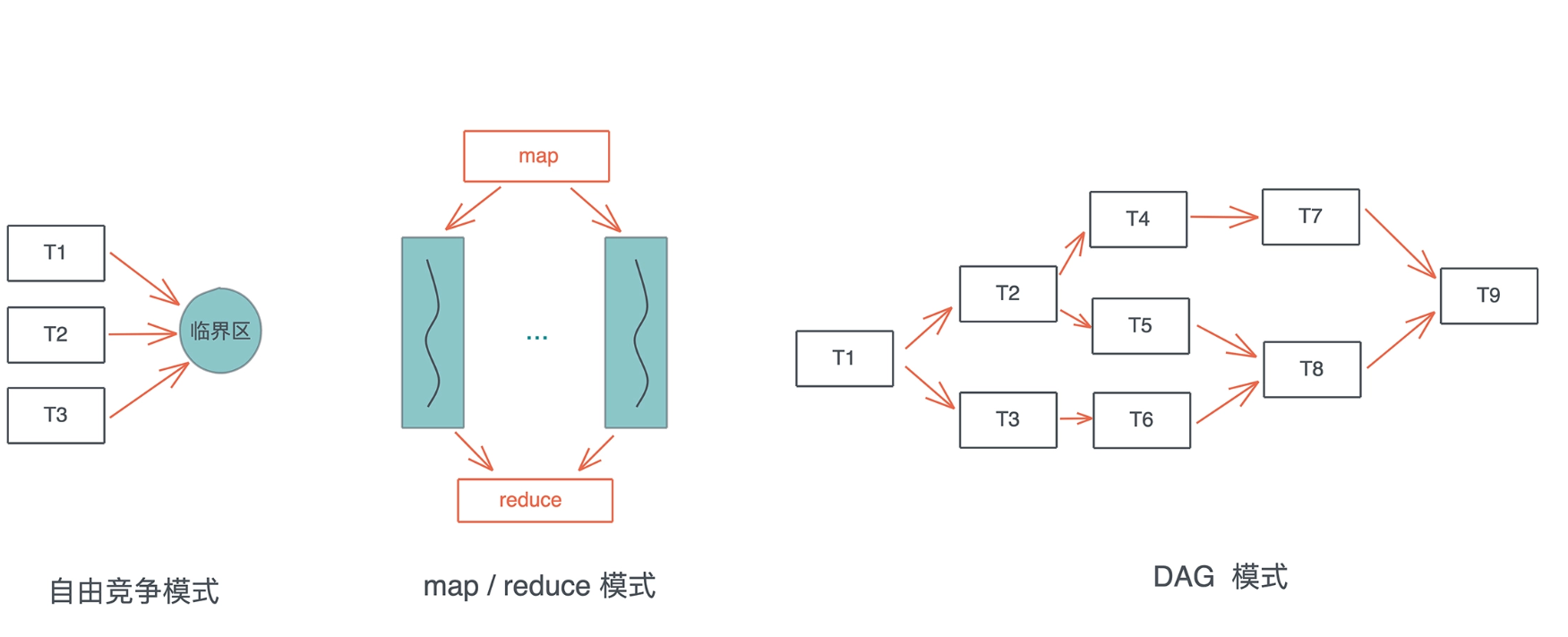

2. 并发常见工作模式

- 自由竞争模式下, 多个并发任务会竞争同一个临界区的访问权

- map/reduce 模式, 把工作打散, 按照相同的处理完成后, 再按照一定的顺序将结果组织起来

- DAG 模式, 把工作切成不相交的、有依赖关系的子任务, 然后按依赖关系并发执行.

3. Atomic

Atomic是所有并发原语的基础, 它为并发任务的同步奠定了坚实的基础.可以通过一条指令读取某个内存地址, 判断其值是否等于某个前置值, 如果相等, 将其修改为新的值. 这就是 Compare-and-swap 操作, 简称CAS

#![allow(unused)] fn main() { pub fn compare_exchange( &self, current: bool, new: bool, success: Ordering, failure: Ordering ) -> Result<bool, bool> pub enum Ordering { Relaxed, Release, Acquire, AcqRel, SeqCst, } }

可以看到 compare_exchange函数有两个和Ordering的奇怪参数, Ordering是一个 enum.

Relaxed: 最宽松的规则, 它对编译器和CPU不做任何限制, 可以乱序执行.Release, 当我们写入数据时, 那么- 对于当前线程, 任何读取或写入操作都不能被乱序排在这个 store 之后.

- 对于其它线程, 任何使用了

Acquire来读取这个atomic的数据, 那么它们看到的是修改后的结果.

Acquire, 当我们读取数据时, 那么- 对于当前线程, 任何读取或者写入操作都不能被乱序排在这个读取之前.

- 对于其它线程, 如果使用了

Release来修改数据, 那么, 修改的值对当前线程可见.

AcqRel是Acquire和Release的结合, 同时拥有Acquire和Release的保证. 这个一般用在fetch_xxx上, 比如你要对一个atomic自增1, 你希望这个操作之前和之后的读取或写入操作不会被乱序, 并且操作的结果对其它线程可见.SeqCst是最严格的Ordering,除了AcqRel的保证外,它还保证所有线程看到的所有SeqCst操作的顺序是一致的.

#![allow(unused)] fn main() { while self .locked .compare_exchange(false, true, Ordering::Acquire, Ordering::Relaxed) .is_err() { // 性能优化: compare_exchange 需要独占访问, 当拿不到锁时, 我们 // 先不停检测 locked 的状态, 直到其 unlocked 后, 再尝试拿锁 while self.locked.load(Ordering::Relaxed) == true {} } }

注意, 我们在

while loop里, 又嵌入了一个loop. 这是因为CAS是个代价比较高的操作, 它需要获得对应内存的独占访问 (exclusive access) , 我们希望失败的时候只是简单读取 atomic 的状态, 只有符合条件的时候再去做独占访问, 进行CAS. 所以, 看上去多做了一层循环, 实际代码的效率更高.

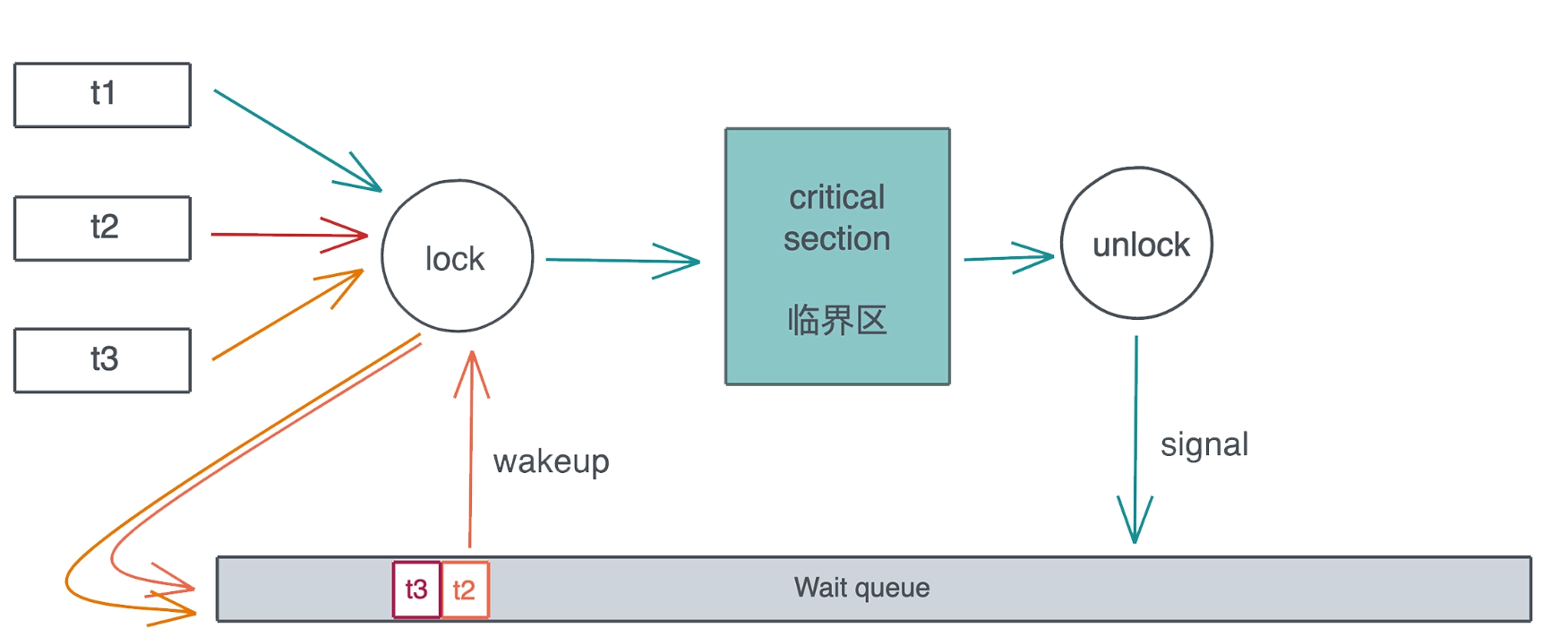

4. Mutex

SpinLock, 顾名思义,就是线程通过CPU 空转(spin, 就像前面的 while loop)忙等 (busy wait) , 来等待某个临界区可用的一种锁. 这种通过 SpinLock做互斥的实现方式有使用场景的限制: 如果受保护的临界区太大, 那么整体的性能会急剧下降, CPU 忙等, 浪费资源还不干实事, 不适合作为一种通用的处理方法.

通用的解决方案是: 当多个线程竞争同一个 Mutex 时, 获得锁的线程得到临界区的访问, 其它线程被挂起, 放入该 Mutex 上的一个等待队列里. 当获得锁的线程完成工作, 退出临界区时, Mutex 会给等待队列发一个信号, 把队列中第一个线程唤醒, 于是这个线程可以进行后续的访问. 整个过程如下:

当然, 这样实现会带来公平性的问题: 如果新来的线程恰巧在 spin 过程中拿到了锁, 而当前等待队列中还有其它线程在等待锁, 那么等待的线程只能继续等待下去, 这不符合 FIFO, 不适合那些需要严格按先来后到排队的使用场景. 为此, parking_lot 提供了 fair mutex.

5. Condvar

操作系统还提供了 Condvar. Condvar 有两种状态:

- 等待 (wait) : 线程在队列中等待, 直到满足某个条件.

- 通知 (notify) : 当

condvar的条件满足时, 当前线程通知其他等待的线程可以被唤醒. 通知可以是单个通知, 也可以是多个通知, 甚至广播 (通知所有人).

6. Channel

Channel 把锁封装在了队列写入和读取的小块区域内, 然后把读者和写者完全分离, 使得读者读取数据和写者写入数据, 对开发者而言, 除了潜在的上下文切换外, 完全和锁无关, 就像访问一个本地队列一样. 所以, 对于大部分并发问题, 我们都可以用 Channel 或者类似的思想来处理 (比如 actor model).

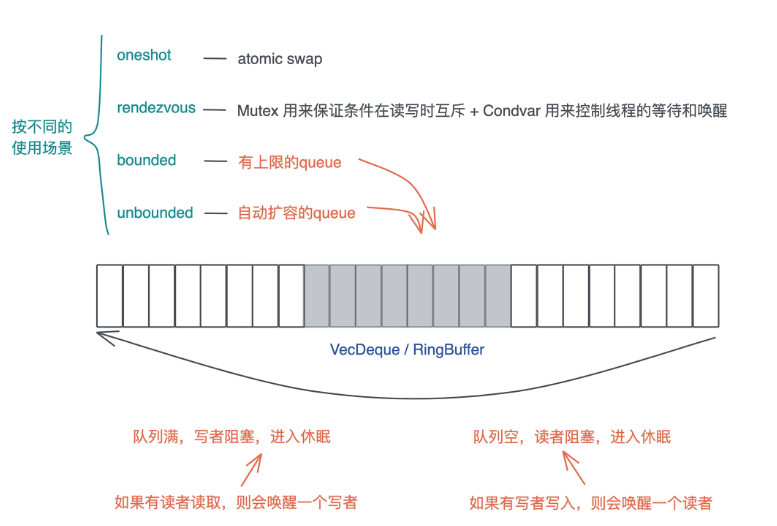

Rust提供了以下四种Channel:

-

oneshot: 这可能是最简单的Channel, 写者就只发一次数据, 而读者也只读一次. 这种一次性的、多个线程间的同步可以用oneshot channel完成. 由于oneshot特殊的用途, 实现的时候可以直接用atomic swap来完成 -

rendezvous: 很多时候, 我们只需要通过Channel来控制线程间的同步, 并不需要发送数据.rendezvous channel是channel size为 0 的一种特殊情况. -

bounded:bounded channel有一个队列, 但队列有上限. 一旦队列被写满了, 写者也需要被挂起等待. 当阻塞发生后, 读者一旦读取数据,channel内部就会使用Condvar的notify_one通知写者, 唤醒某个写者使其能够继续写入. -

unbounded:queue没有上限, 如果写满了, 就自动扩容. 我们知道,Rust的很多数据结构如Vec、VecDeque都是自动扩容的.unbounded和bounded相比, 除了不阻塞写者, 其它实现都很类似.

根据 Channel 读者和写者的数量, Channel 又可以分为:

SPSC: Single-Producer Single-Consumer, 单生产者, 单消费者. 最简单, 可以不依赖于Mutex, 只用atomics就可以实现.SPMC: Single-Producer Multi-Consumer, 单生产者, 多消费者. 需要在消费者这侧读取时加锁.MPSC: Multi-Producer Single-Consumer, 多生产者, 单消费者. 需要在生产者这侧写入时加锁.MPMC: Multi-Producer Multi-Consumer. 多生产者, 多消费者. 需要在生产者写入或者消费者读取时加锁.

7. Actor

actor model, actor 是一种有栈协程. 每个 actor, 有自己的一个独立的、轻量级的调用栈, 以及一个用来接受消息的消息队列 (mailbox 或者 message queue) , 外界跟 actor 打交道的唯一手段就是, 给它发送消息.

9. 参考

- Robe Pike 的演讲 concurrency is not parallelism

- Jon Gjengset 的视频: Crust of Rust: Atomics and Memory Ordering

- Rust 的 spin-rs crate 提供了

Spinlock的实现 - atcix actor 实现

- bastion actor 实现

- concurrent hash map: dashmap , left-right

宏 macro

宏在 Rust 里指的是一组相关特性的集合称谓:

- 使用

macro_rules!构建的声明宏 (declarative macro) - 3 种过程宏

- 自定义

#[derive]宏, 用于struct 或enum, 可以为其指定随derive属性添加的代码 - 类似属性的宏, 在任何条目上添加自定义属性

- 类似函数的宏, 看起来像函数调用, 对其指定为参数的 token 进行操作

- 自定义

1. 宏与函数的差别

-

宏是用来编写可以生成其它代码的代码, 即所谓的 元编程(metaprogramming)

-

函数在定义签名时, 必须声明参数的个数和类型,

-

宏可处理可变的参数

-

编译器会在解释代码前展开宏

-

宏的定义比函数复杂得多, 难以阅读,理解, 维护

-

在某个文件调用宏时, 必须提前定义宏或将宏引入当前作用哉

-

函数可以在任何位置定义,并在任何位置使用

2. macro_rules!声明宏

#![allow(unused)] fn main() { #[macro_export] macro_rules! vec { ( $( $x: expr ),* ) => { { let mut temp_vec = Vec::new(); $( temp_vec.push($x); )* temp_vec } } } // 此处有一个单边模式 ( $( $x: expr ),* ), 后跟 => 和模式相关的代码块. 如果模式匹配, 代码将被执行. 更复杂的宏会有多个单边模式. // $x: expr 匹配任何rust的表达式,并命名为x // $( $x: expr ),* 表示匹配*号前0个或1个表达式 }

3. 过程宏

这种形式更像函数

- 接收并操作输入的Rust代码

- 生成另外一些Rust代码结果

三种过程宏:

- 自定义派生

- 属性宏

- 函数宏

Note: 创建过程宏时, 宏定义必须单独放在它们自己的包中, 并使用特殊的包类型

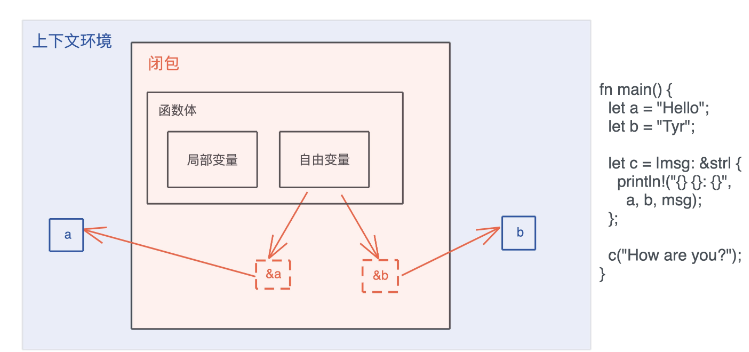

闭包(closure): FnOnce, FnMut, Fn

1. 闭包定义

闭包是将函数, 或者说代码和其环境一起存储的一种数据结构. 闭包引用的上下文中的自由变量, 会被捕获到闭包的结构中, 成为闭包类型的一部分

在 Rust 里, 闭包可以用 |args| { code } 来表述, 除了用引用来捕获自由变量之外, 还有另外一个方法使用 move 关键字 move |args| { code }

图中闭包 c 捕获了上下文中的 a 和 b, 并通过引用来使用这两个自由变量:

2. 闭包的本质

-

闭包是一种匿名类型, 一旦声明, 就会产生一个新的类型, 但这个类型无法被其它地方使用. 这个类型就像一个结构体, 会包含所有捕获的变量.

-

闭包的大小跟参数、局部变量都无关, 只跟捕获的变量有关.

-

闭包是存储在栈上, 并且除了捕获的数据外, 闭包本身不包含任何额外函数指针指向闭包的代码

-

闭包变量的所有权:

- 如果不使用

move转移所有权, 闭包会引用上下文中的变量, 这个引用受借用规则的约束, 所以只要编译通过, 那么闭包对变量的引用就不会超过变量的生命周期, 没有内存安全问题. - 如果使用

move转移所有权, 上下文中的变量在转移后就无法访问, 闭包完全接管这些变量, 它们的生命周期和闭包一致, 所以也不会有内存安全问题.

- 如果不使用

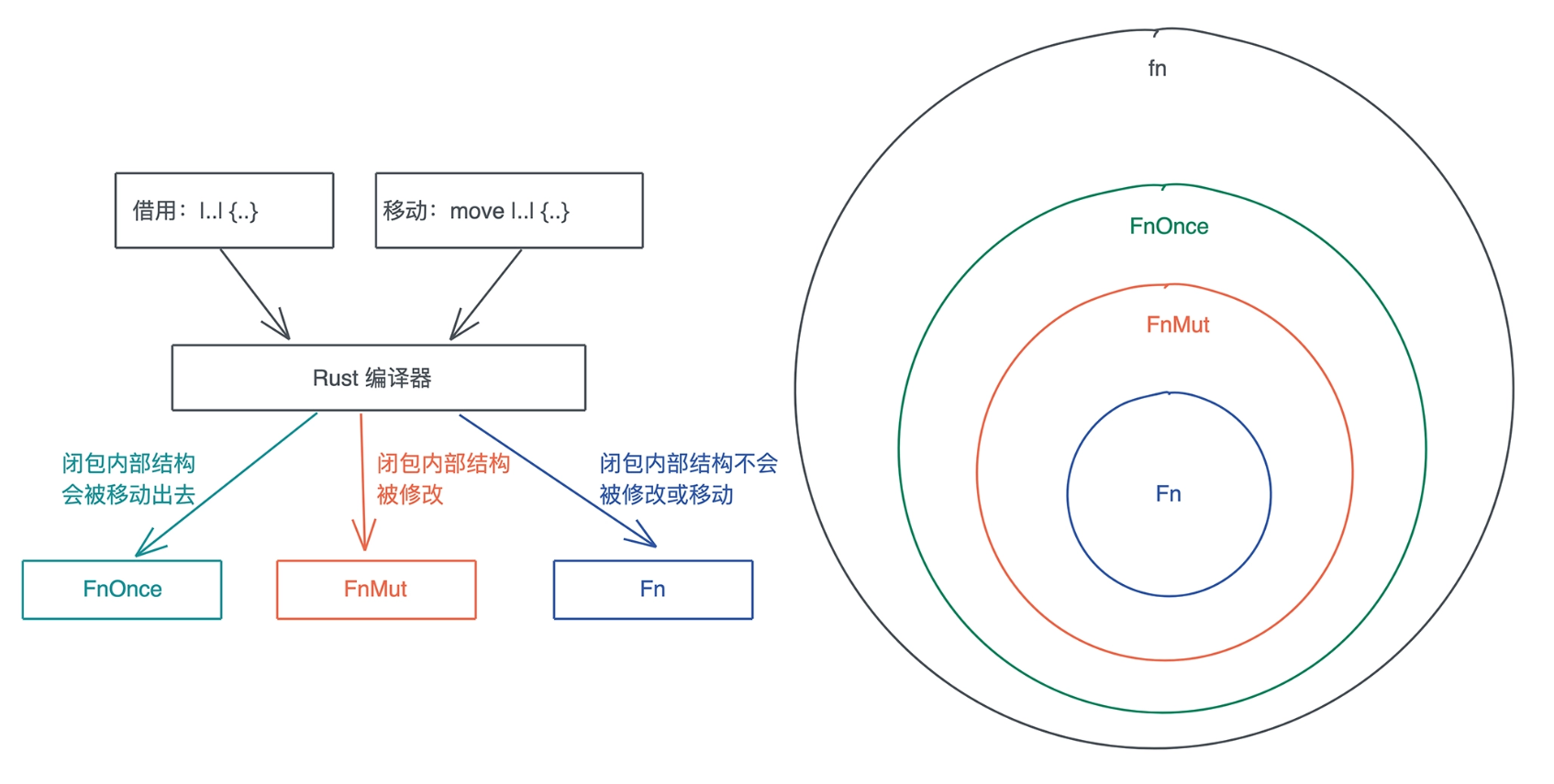

3. 闭包类型

FnOnce / FnMut / Fn 这三种闭包类型有什么区别.

3.1 FnOnce

#![allow(unused)] fn main() { pub trait FnOnce<Args> { type Output; extern "rust-call" fn call_once(self, args: Args) -> Self::Output; } }

FnOnce有一个关联类型, 这是闭包的返回值类型, 还有一个方法 call_once, 注意call_once第一个参数是self,它会转移self的所有权到call_once函数中.

这也是为什么FnOnce被称为 Once: 它只能被调用一次, 再次调用, 编译器将报变量已被 move 的所有权错误.

FnOnce 的参数, 是一个叫 Args 的泛型参数, 它并没有任何约束.

fn main() { let name = String::from("Tyr"); // 这个闭包啥也不干, 只是把捕获的参数返回去 // 这是一个FnOnce闭包 let c = move |greeting: String| (greeting, name); let result = c("hello".to_string()); println!("result: {:?}", result); // 无法再次调用 let result = c("hi".to_string()); }

3.2 FnMut

#![allow(unused)] fn main() { pub trait FnMut<Args>: FnOnce<Args> { extern "rust-call" fn call_mut(&mut self, args: Args) -> Self::Output; } }

FnMut“继承”了FnOnce, 所以FnMut也拥有Output这个关联类型和call_once这个方法. 此外, 它还有一个call_mut()方法. 注意call_mut()传入&mut self, 它不移动self, 所以FnMut可以被多次调用.FnMut“继承”了FnOnce, 所以, 一个FnMut闭包, 可以被传给一个需要FnOnce的上下文, 此时调用闭包相当于调用了call_once().

fn main() { let mut name = String::from("hello"); // 捕获 &mut name let mut c = || { name.push_str(" Tyr"); println!("c: {}", name); }; call_mut(&mut c); call_once(c); } // 在作为参数时, FnMut 也要显式地使用 mut, 或者 &mut fn call_mut(c: &mut impl FnMut()) { c(); } // 为啥 call_once 不需要 mut? fn call_once(c: impl FnOnce()) { c(); }

3.3 Fn

#![allow(unused)] fn main() { pub trait Fn<Args>: FnMut<Args> { extern "rust-call" fn call(&self, args: Args) -> Self::Output; } }

Fn“继承”了 FnMut. 这也就意味着任何需要 FnOnce 或者 FnMut 的场合, 都可以传入满足 Fn 的闭包

fn main() { let v = vec![0u8; 1024]; // Fn, 不移动所有权 let mut c = |x: u64| v.len() as u64 * x; // Fn, 移动所有权 // let mut c = move |x: u64| v.len() as u64 * x; println!("direct call: {}", c(2)); println!("call: {}", call(3, &c)); println!("call_mut: {}", call_mut(4, &mut c)); println!("call_once: {}", call_once(5, c)); } fn call(arg: u64, c: &impl Fn(u64) -> u64) -> u64 { c(arg) } fn call_mut(arg: u64, c: &mut impl FnMut(u64) -> u64) -> u64 { c(arg) } fn call_once(arg: u64, c: impl FnOnce(u64) -> u64) -> u64 { c(arg) }

3.4 闭包使用场景

-

作为参数

-

作为函数返回值

-

为它实现某个

trait- 使其能表现出其他行为, 而不仅仅作为函数被调用. 比如有些接口既可以传入一个结构体, 又可以传入一个函数或者闭包.

#![allow(unused)] fn main() { pub trait Interceptor { /// Intercept a request before it is sent, optionally cancelling it. fn call(&mut self, request: crate::Request<()>) -> Result<crate::Request<()>, Status>; } impl<F> Interceptor for F where F: FnMut(crate::Request<()>) -> Result<crate::Request<()>, Status>, { fn call(&mut self, request: crate::Request<()>) -> Result<crate::Request<()>, Status> { self(request) } } }

Interceptor有一个call方法, 它可以让 gRPC Request 被发送出去之前被修改, 一般是添加各种头, 比如Authorization头.

4.总结

Rust 闭包的效率非常高. 首先闭包捕获的变量, 都储存在栈上, 没有堆内存分配. 其次因为闭包在创建时会隐式地创建自己的类型, 每个闭包都是一个新的类型. 通过闭包自己唯一的类型, Rust 不需要额外的函数指针来运行闭包, 所以闭包的调用效率和函数调用几乎一致.

错误处理

1. Option 和 Result

Option 是一个 enum, 它可以承载有值 / 无值这种最简单的错误类型.

其定义如下:

#![allow(unused)] fn main() { pub enum Option<T> { None, Some(T), }

Result 是一个更加复杂的 enum, 当函数出错时, 可以返回 Err(E), 否则 Ok(T).

其定义如下:

#![allow(unused)] fn main() { #[must_use = "this `Result` may be an `Err` variant, which should be handled"] pub enum Result<T, E> { Ok(T), Err(E), } }

2. ? 操作符

好在 Rust 除了有强大的类型系统外, 还具备元编程的能力, 所以在 Rust 代码中, 如果你只想传播错误, 不想就地处理, 可以用 ? 操作符.

? 操作符内部被展开成类似下面的代码:

#![allow(unused)] fn main() { match result { Ok(v) => v, Err(e) => return Err(e.into()) } }

在不同的错误类型之间是无法直接使用的, 注意上面的 e.into(), 需要实现 From trait 在二者之间建立起转换的桥梁

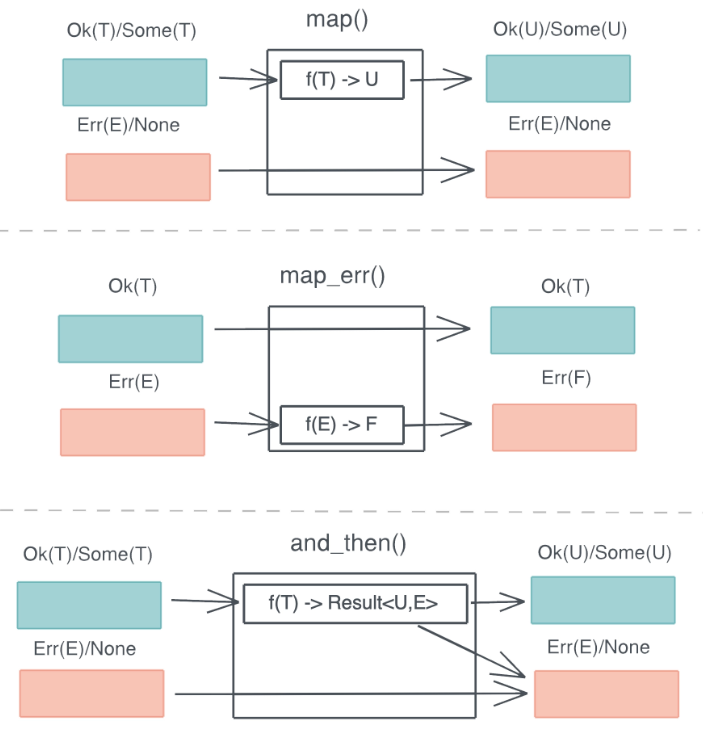

3. 函数式错误处理

Rust 还为 Option 和 Result 提供了大量的辅助函数, 如 map / map_err / and_then, 你可以很方便地处理数据结构中部分情况. 如下图所示:

通过这些函数, 你可以很方便地对错误处理引入Railroad oriented programming 范式

4. panic! 和 catch_unwind

panic! 是不可恢复或者不想恢复的错误, 我们希望在此刻, 程序终止运行并得到崩溃信息.

Rust 标准库下提供了 catch_unwind() , 把调用栈回溯到 catch_unwind 这一刻你就可以把 Rust 代码整个封装在 catch_unwind() 函数所需要传入的闭包中. 这样, 一旦任何代码中, 包括第三方 crates 的代码, 含有能够导致 panic! 的代码, 都会被捕获, 并被转换为一个 Result.

5. Error trait 和 错误的转换

为了规范这个代表错误的数据类型的行为, Rust 定义了 Error trait:

#![allow(unused)] fn main() { pub trait Error: Debug + Display { fn source(&self) -> Option<&(dyn Error + 'static)> { ... } fn backtrace(&self) -> Option<&Backtrace> { ... } fn description(&self) -> &str { ... } fn cause(&self) -> Option<&dyn Error> { ... } } }

我们可以使用 thiserror和 anyhow 来简化这个步骤. thiserror 提供了一个派生宏(derive macro)来简化错误类型的定义.

智能指针

在 Rust 中, 凡是需要做资源回收的数据结构, 且实现了 Deref/DerefMut/Drop, 都是智能指针.

#![allow(unused)] fn main() { pub trait Deref { type Target: ?Sized; fn deref(&self) -> &Self::Target; } pub trait DerefMut: Deref { fn deref_mut(&mut self) -> &mut Self::Target; } pub trait Drop { fn drop(&mut self); } }

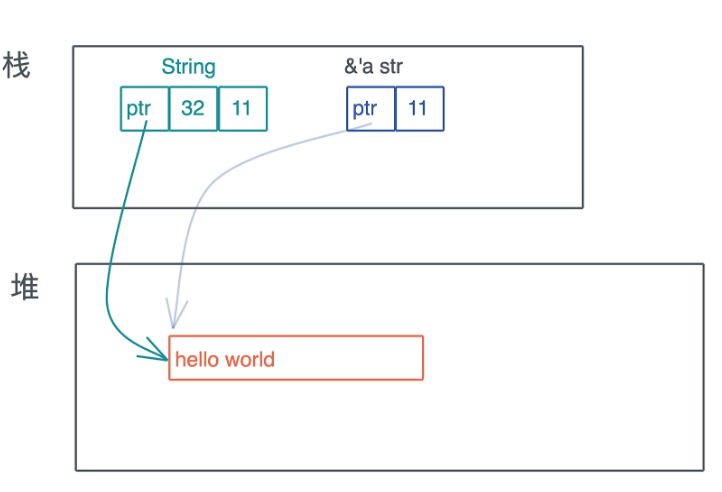

1. String 和 &str

智能指针一定是一个胖指针, 但胖指针不一定是一个智能指针, 比如 &str 就只是一个胖指针, 它有指向堆内存字符串的指针, 同时还有关于字符串长度的元数据.

智能指针 String 和 &str 的区别:

但 String 对堆上的值有所有权, 而 &str 是没有所有权的, 这是 Rust 中智能指针和普通胖指针的区别.

String 是用结构体定义的.

#![allow(unused)] fn main() { pub struct String { vec: Vec<u8>, } }

和普通的结构体不同的是, String 实现了 Deref 和 DerefMut, 这使得它在解引用的时候, 会得到 &str

#![allow(unused)] fn main() { impl ops::Deref for String { type Target = str; fn deref(&self) -> &str { unsafe { str::from_utf8_unchecked(&self.vec) } } } impl ops::DerefMut for String { fn deref_mut(&mut self) -> &mut str { unsafe { str::from_utf8_unchecked_mut(&mut *self.vec) } } } }

由于在堆上分配了数据, String 还需要为其分配的资源做相应的回收. 而 String 内部使用了 Vec, 所以它可以依赖 Vec 的能力来释放堆内存.

#![allow(unused)] fn main() { unsafe impl<#[may_dangle] T, A: Allocator> Drop for Vec<T, A> { fn drop(&mut self) { unsafe { // use drop for [T] // use a raw slice to refer to the elements of the vector as weakest necessary type; // could avoid questions of validity in certain cases ptr::drop_in_place(ptr::slice_from_raw_parts_mut(self.as_mut_ptr(), self.len)) } // RawVec handles deallocation } } }

2. Box<T>

Box<T> 的定义里, 内部就是一个 Unique<T> 用于致敬 C++, Unique<T> 是一个私有的数据结构, 我们不能直接使用, 它包裹了一个 *const T 指针, 并唯一拥有这个指针.

#![allow(unused)] fn main() { pub struct Unique<T: ?Sized> { pointer: *const T, // NOTE: this marker has no consequences for variance, but is necessary // for dropck to understand that we logically own a `T`. // // For details, see: // https://github.com/rust-lang/rfcs/blob/master/text/0769-sound-generic-drop.md#phantom-data _marker: PhantomData<T>, } pub struct Box<T: ?Sized,A: Allocator = Global>(Unique<T>, A) }

3. Cow<'a, B>

Cow 是 Rust 下用于提供写时克隆 (Clone-on-Write) 的一个智能指针, 它跟虚拟内存管理的写时复制 (Copy-on-write) 有异曲同工之妙: **包裹一个只读借用, 但如果调用者需要所有权或者需要修改内容, 那么它会 clone 借用的数据. **

#![allow(unused)] fn main() { pub enum Cow<'a, B> where B: 'a + ToOwned + ?Sized { Borrowed(&'a B), // 对类型 B 的只读引用 Owned(<B as ToOwned>::Owned), // 包含对类型 B 的拥有所有权的数据 } }

这里引入了两个 trait, 首先是ToOwned, 在ToOwner trait 定义的时候, 又引入了 Borrow trait, 它们都是 std::borrow 下的 trait.

#![allow(unused)] fn main() { pub trait ToOwned { type Owned: Borrow<Self>; #[must_use = "cloning is often expensive and is not expected to have side effects"] fn to_owned(&self) -> Self::Owned; fn clone_into(&self, target: &mut Self::Owned) { ... } } pub trait Borrow<Borrowed> where Borrowed: ?Sized { fn borrow(&self) -> &Borrowed; } }

首先 Owned: Borrow<Self> 是一个带有关联类型的 trait, 这里的 Owned 关联类型, 需要使用者定义, 并且这里的Owned 不能是任意类型, 它必须满足 Borrow<T> trait. 例如 str对 ToOwner trait 的实现:

#![allow(unused)] fn main() { impl ToOwned for str { type Owned = String; #[inline] fn to_owned(&self) -> String { unsafe { String::from_utf8_unchecked(self.as_bytes().to_owned()) } } fn clone_into(&self, target: &mut String) { let mut b = mem::take(target).into_bytes(); self.as_bytes().clone_into(&mut b); *target = unsafe { String::from_utf8_unchecked(b) } } } }

可以看到关联类型 Owned 被定义为 String, 而根据要求, String 必须定义 Borrow, 那这里 Borrow 里的泛型变量 T 是谁呢?

ToOwned 要求是 Borrow, 而此刻实现 ToOwned 的主体是 str, 所以 Borrow 是 Borrow<str>, 也就是说 String 要实现 Borrow<str>, 我们看文档, 它的确实现了这个 trait:

#![allow(unused)] fn main() { impl Borrow<str> for String { #[inline] fn borrow(&self) -> &str { &self[..] } } }

Cow说它是智能指针, 那它自然需要实现 Deref trait:

#![allow(unused)] fn main() { impl<B: ?Sized + ToOwned> Deref for Cow<'_, B> { type Target = B; fn deref(&self) -> &B { match *self { Borrowed(borrowed) => borrowed, Owned(ref owned) => owned.borrow(), } } } }

这种根据 enum 的不同状态来进行统一分发的方法是第三种分发手段, 可以使用泛型参数做静态分发和使用 trait object 做动态分发.

4. MutexGuard<T>

MutexGuard<T> 是一类很有意思的智能指针: 它不但通过 Deref 提供良好的用户体验, 还通过 Drop trait 来确保, 使用到的内存以外的资源在退出时进行释放.

MutexGuard这个结构是在调用 Mutex::lock 时生成的:

#![allow(unused)] fn main() { pub fn lock(&self) -> LockResult<MutexGuard<'_, T>> { unsafe { self.inner.raw_lock(); MutexGuard::new(self) } } }

MutexGuard 的定义以及它的 Deref 和 Drop 的实现,

#![allow(unused)] fn main() { // 这里用 must_use, 当你得到了却不使用 MutexGuard 时会报警 #[must_use = "if unused the Mutex will immediately unlock"] pub struct MutexGuard<'a, T: ?Sized + 'a> { lock: &'a Mutex<T>, poison: poison::Guard, } impl<T: ?Sized> Deref for MutexGuard<'_, T> { type Target = T; fn deref(&self) -> &T { unsafe { &*self.lock.data.get() } } } impl<T: ?Sized> DerefMut for MutexGuard<'_, T> { fn deref_mut(&mut self) -> &mut T { unsafe { &mut *self.lock.data.get() } } } impl<T: ?Sized> Drop for MutexGuard<'_, T> { #[inline] fn drop(&mut self) { unsafe { self.lock.poison.done(&self.poison); self.lock.inner.raw_unlock(); } } } }

MuxteGuard 不允许Send, 只允许Sync. 就是说, 你可以把 MutexGuard 的引用传给另一个线程使用, 但你无法把 MutexGuard 整个 move 到另一个线程.

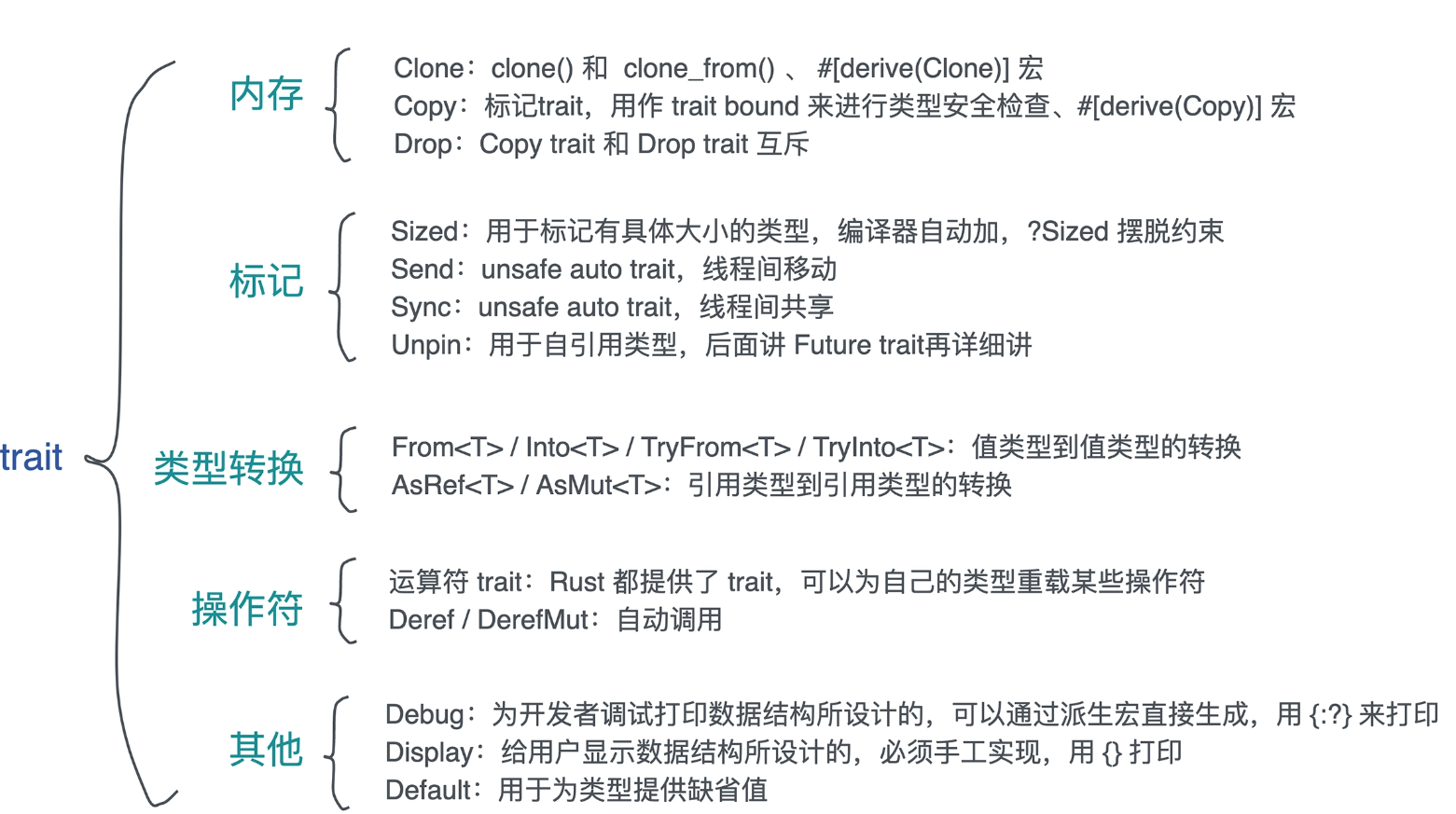

标准 trait

1. 内存相关: Clone/Copy/Drop

1.1 Clone trait

#![allow(unused)] fn main() { pub trait Clone { fn clone(&self) -> Self; fn clone_from(&mut self, source: &Self) { *self = source.clone() } } }

clone_from方法在实例a已经存在, 在clone过程中会分配内存, 那么用a.clone_from(&b)可以避免内存分配, 提高效率.

Clone trait可以通过派生宏直接实现#[derive(Clone)].

1.2 Copy trait

#![allow(unused)] fn main() { pub trait Copy: Clone {} }

这个trait没有任何行为, 但它可以用作 trait bound 来进行类型安全检查, 所以叫 标志trait

Copy trait可以通过派生宏直接实现#[derive(Copy)].

1.3 Drop trait

#![allow(unused)] fn main() { pub trait Drop { fn drop(&mut self); } }

大部分场景无需为数据结构提供 Drop trait, 系统默认会依次对数据结构的每个域做 drop. 但有两种情况你可能需要手工实现 Drop.

- 希望在数据结束生命周期的时候做一些事情, 比如记日志.

- 需要对资源回收的场景. 编译器并不知道你额外使用了哪些资源, 也就无法帮助你

drop它们. 比如说锁资源的释放, 在MutexGuard中实现了Drop来释放锁资源

注意:

Copy trait和Drop trait是互斥的, 两者不能共存, 当你尝试为同一种数据类型实现Copy时, 同时也实现Drop, 编译器就会报错. 这其实很好理解:**Copy是按位做浅拷贝, 那么它会默认拷贝的数据没有需要释放的资源;而Drop恰恰是为了释放额外的资源而生的. **

2. 标记 trait: Sized/Send/Sync/Unpin

2.1 Sized trait

#![allow(unused)] fn main() { pub trait Sized { } }

Sized trait 用于标记有具体大小的类型. 在使用泛型参数时, Rust 编译器会自动为泛型参数加上 Sized 约束.

大部分时候, 我们都希望能自动添加这样的约束, 因为这样定义出的泛型结构, 在编译期, 大小是固定的, 可以作为参数传递给函数.

在少数情况下, 需要 T 是可变类型的 那么需要?Sized 来摆脱这个约束.

#![allow(unused)] fn main() { // 这样B就可以是[T]或者str类型,大小都不固定. // 注意 Borrowed(&'a B) 大小是固定的, 因为它是对B的一个引用, 而且引用的大小是固定的. pub enum Cow<'a, B: ?Sized + 'a> where B: ToOwned, { // 借用的数据 Borrowed(&'a B), // 拥有的数据 Owned(<B as ToOwned>::Owned), } }

2.2 Send/Sync

#![allow(unused)] fn main() { pub unsafe auto trait Send {} pub unsafe auto trait Sync {} }

这两个 trait 都是 unsafe auto trait, auto 意味着编译器会在合适的场合, 自动为数据结构添加它们的实现, 而 unsafe 代表实现的这个 trait 可能会违背 Rust 的内存安全准则, 如果开发者手工实现这两个 trait , 要自己为它们的安全性负责.

Send/Sync 是 Rust 并发安全的基础:

- 如果一个类型

T实现了Send trait, 意味着T可以安全地从一个线程移动到另一个线程, 也就是说所有权可以在线程间移动. - 如果一个类型

T实现了Sync trait, 则意味着&T可以安全地在多个线程中共享. 一个类型T满足Sync trait, 当且仅当&T满足Send trait.

对于 Send/Sync 在线程安全中的作用, 可以这么看, **如果一个类型 T: Send, 那么 T 在某个线程中的独占访问是线程安全的;如果一个类型 T: Sync, 那么 T 在线程间的只读共享是安全的. **

对于我们自己定义的数据结构, 如果其内部的所有域都实现了 Send / Sync, 那么这个数据结构会被自动添加 Send / Sync.

标准库中, 不支持 Send / Sync 的数据结构主要有:

- 裸指针

*const T/*mut T. 它们是不安全的, 所以既不是Send也不是Sync. UnsafeCell不支持Sync. 也就是说, 任何使用了Cell或者RefCell的数据结构不支持Sync.- 引用计数

Rc不支持Send也不支持Sync. 所以Rc无法跨线程.

2.3 Unpin

todo.

3. 类型转换: From/Into/AsRef/AsMut

3.1 From / Into 和 TryFrom / TryInto

#![allow(unused)] fn main() { pub trait From<T> { fn from(T) -> Self; } pub trait Into<T> { fn into(self) -> T; } // 实现 From 会自动实现 Into impl<T, U> Into<U> for T where U: From<T> { fn into(self) -> U { U::from(self) } } // From(Into)是自反的 // 把类型 T 的值转换成类型 T, 会直接返回 impl<T> From<T> for T { fn from(t: T) -> T { t } } }

From<T> 可以根据上下文做类型推导, 使用场景更多;而且实现了 From<T> 会自动实现 Into<T>, 反之不会. 所以需要的时候, 只要实现 From<T> 即可.

而且From<T>(Into<T>)是自反的, 把类型 T 的值转换成类型 T, 会直接返回, 这样在接口设计时变得灵活, 比如函数接受一个IpAddr为参数, 我们可以使用Into<IpAddr>让更多的类型被这个函数使用.

#![allow(unused)] fn main() { use std::net::IpAddr; fn print(v: impl Into<IpAddr>) { println!("{:?}", v.into()); } }

合理地使用From<T> / Into<T>, 可以让代码变得简洁, 符合 Rust 可读性强的风格, 更符合开闭原则.

注意, 如果你的数据类型在转换过程中有可能出现错误, 可以使用 TryFrom<T> 和 TryInto<T>, 用法与From<T>/ Into<T> 一样

#![allow(unused)] fn main() { pub trait TryFrom<T> { type Error; fn try_from(value: T) -> Result<Self, Self::Error>; } pub trait TryInto<T> { type Error; fn try_into(self) -> Result<T, Self::Error>; } }

3.2 AsRef / AsMut

AsRef<T> 和 AsMut<T> 就很好理解了, 用于从引用到引用的转换.

在 trait 的定义上, 都允许 T 使用大小可变的类型, 如 str、[u8] 等. AsMut<t> 除了使用可变引用生成可变引用外, 其它都和 AsRef<T> 一样.

注意, 如果你的代码出现 v.as_ref().clone() 这样的语句, 也就是说你要对 v 进行引用转换, 然后又得到了拥有所有权的值, 那么你应该实现 From<T>, 然后做 v.into().

#![allow(unused)] fn main() { pub trait AsRef<T> where T: ?Sized { fn as_ref(&self) -> &T; } pub trait AsMut<T> where T: ?Sized { fn as_mut(&mut self) -> &mut T; } }

4. Deref / DerefMut

#![allow(unused)] fn main() { pub trait Deref { // 解引用出来的结果类型 type Target: ?Sized; fn deref(&self) -> &Self::Target; } pub trait DerefMut: Deref { fn deref_mut(&mut self) -> &mut Self::Target; } }

5. Debug / Display / Default

#![allow(unused)] fn main() { pub trait Debug { fn fmt(&self, f: &mut Formatter<'_>) -> Result<(), Error>; } pub trait Display { fn fmt(&self, f: &mut Formatter<'_>) -> Result<(), Error>; } pub trait Default { fn default() -> Self; } }

Debug 和 Display 两个 trait 的签名一样, 都接受一个 &self 和一个 &mut Formatter.

Debug是为开发者调试打印数据结构所设计的, 可以通过派生宏直接生成.通过{:?}来打印.Display是给用户显示数据结构所设计的, 必须手工实现.通过{}打印.

Default trait 用于为类型提供缺省值. 它也可以通过 derive 宏 #[derive(Default)] 来生成实现, 前提是类型中的每个字段都实现了 Default trait.

总结

类型系统: 泛型

1. 泛型参数的三种使用场景

- 使用泛型参数延迟数据结构的绑定

- 使用泛型参数和

PhantomData, 声明数据结构中不直接使用, 但在实现过程中需要用到的类型. - 使用泛型参数让同一个数据结构对同一个

trait可以有不同的实现

1.1 泛型参数做延迟绑定

#![allow(unused)] fn main() { /// Service 数据结构 pub struct Service<Store = MemTable> { inner: Arc<ServiceInner<Store>>, } }

它使用了一个泛型参数Store, 并且这个泛型参数有一个缺省值, 在使用时可以不必提供泛型参数, 直接使用缺省值. 这个泛型参数在随后的实现中可以被逐渐约束.

#![allow(unused)] fn main() { impl<Store> Service<Store> { pub fn new(store: Store) -> Self { ... } } impl<Store: Storage> Service<Store> { pub fn execute(&self, cmd: CommandRequest) -> CommandResponse { ... } } }

1.2 使用泛型参数和幽灵数据 (PhantomData) 提供额外类型

设计一个 User 和 Product 数据结构, 它们都有一个 u64 类型的 id. 然而我希望每个数据结构的 id 只能和同种类型的 id 比较.

#![allow(unused)] fn main() { use std::marker::PhantomData; #[derive(Debug, Default, PartialEq, Eq)] pub struct Identifier<T> { inner: u64, _tag: PhantomData<T>, } #[derive(Debug, Default, PartialEq, Eq)] pub struct User { id: Identifier<Self>, } #[derive(Debug, Default, PartialEq, Eq)] pub struct Product { id: Identifier<Self>, } #[cfg(test)] mod tests { use super::*; #[test] fn id_should_not_be_the_same() { let user = User::default(); let product = Product::default(); // 两个 id 不能比较, 因为他们属于不同的类型 // assert_ne!(user.id, product.id); assert_eq!(user.id.inner, product.id.inner); } } }

让我们可以用 PhantomData 来持有 Phantom Type. PhantomData 中文一般翻译成幽灵数据, 这名字透着一股让人不敢亲近的邪魅, 但它被**广泛用在处理, 数据结构定义过程中不需要, 但是在实现过程中需要的泛型参数. **

1.3 使用泛型参数来提供多个实现

用泛型数据结构来统一相同的逻辑, 用泛型参数的具体类型来处理变化的逻辑.

我们写代码的首要目标是正确地实现所需要的功能, 在正确性的前提下, 优雅简洁的表达才有意义.

类型系统: trait

参考资料

用于处理借用数据的模块: std::borrow

1 Borrow

#![allow(unused)] fn main() { pub trait Borrow<Borrowed> where Borrowed: ?Sized, { // Required method fn borrow(&self) -> &Borrowed; } }

一个用于借用数据的trait.

通过实现Borrow<T>来表达它们可以作为其个类型T借出.并在trait的borrow方法中提供对T的引用.

例如: String实现了Borrow<str>,则可以作为str进行借出, Box<T>实现了Borrow<T>,则可以作为T进行借出

2. BorrowMut

#![allow(unused)] fn main() { pub trait BorrowMut<Borrowed>: Borrow<Borrowed> where Borrowed: ?Sized, { // Required method fn borrow_mut(&mut self) -> &mut Borrowed; } }

一个用于可变借用数据的trait.

作为Borrow<T>的补充,该trait允许类型通过提供可变引用来借用底层类型.

3. ToOwned

#![allow(unused)] fn main() { pub trait ToOwned { type Owned: Borrow<Self>; // Required method fn to_owned(&self) -> Self::Owned; // Provided method fn clone_into(&self, target: &mut Self::Owned) { ... } } }

Clone在借用数据上的泛化.

Clone一般是&T到T, ToOwned trait 将Clone泛化, 可以从给定类型的任何借用中构造拥有数据.

这里关联类型Owned需要满足Borrow<Self> trait, 此处Self为要实现ToOwned的结构.

看下 str对ToOwned trait 的实现:

#![allow(unused)] fn main() { impl ToOwned for str { type Owned = String // Required method fn to_owned(&self) -> Self::Owned { ... } // Provided method fn clone_into(&self, target: &mut Self::Owned) { ... } } }

关联类型Owned被定义为String, 而根据要求,String必须定义Borrow<T>,那这里Borrow里的泛型变量T是谁呢?

ToOwned要求是Borrow<Self>,而此刻实现 ToOwned 的主体是 str,所以 Borrow<Self> 是 Borrow<str>, 而String的确实现了Borrow<str>.

4. Cow

#![allow(unused)] fn main() { pub enum Cow<'a, B> where B: 'a + ToOwned + ?Sized, { Borrowed(&'a B), Owned(<B as ToOwned>::Owned), } }

Cow用于提供写时克隆(Clone-on-Write)的一个智能指针,包裹一个只读借用,但如果调用者需要所有权或者需要修改内容,那么它会 clone 借用的数据.

Cow实现了Deref trait.

#![allow(unused)] fn main() { impl<B: ?Sized + ToOwned> Deref for Cow<'_, B> { type Target = B; fn deref(&self) -> &B { match *self { Borrowed(borrowed) => borrowed, Owned(ref owned) => owned.borrow(), } } } }

如何阅读源码

以下是 Rust 文档为例

读Rust代码的基本顺序:

- 从

crate的大纲开始, 先了解目标代码能干什么,怎么用. - 学习核心

trait, 看看它支持哪些功能. - 掌握主要的数据结构, 开始写一些示例代码

- 围绕自己感兴趣的情景深入阅读.

1. 从大纲开始

Rust 几乎所有库的文档都在 docs.rs 下, 比如 Bytes 的文档可以通过 docs.rs/bytes 访问

- trait

- struct

- 函数/方法

和写代码的思考方式非常类似:

- 先从需求的流程中敲定系统的行为, 需要定义什么接口 trait;

- 再考虑系统有什么状态, 定义了哪些数据结构 struct;

- 最后到实现细节, 包括如何为数据结构实现 trait、数据结构自身有什么算法、如何把整个流程串起来等等.

2. 熟悉核心 trait 的行为

所以先看 trait, 我们以 Buf trait 为例. 点进去看文档, 主页面给了这个 trait 的定义和一个使用示例.

左侧导航栏的 “required Methods” 和 “Provided Methods”, 前者是实现这个 trait 需要实现的方法, 后者是缺省方法.

导航栏继续往下拉, 可以看到 bytes 为哪些 “foreign types” 实现了 Buf trait, 以及当前模块有哪些 implementors.

可以学习到高手定义 trait 的一些思路:

- 定义好

trait后, 可以考虑一下标准库的数据结构, 哪些可以实现这个 trait. - 如果未来别人的某个类型

T, 实现了你的trait, 那他的&T、&mut T、Box等衍生类型, 是否能够自动实现这个 trait.

3. 掌握主要的 struct

和 trait 类似的, 在左侧的导航栏, 有一些值得关注的信息:这个数据结构有哪些方法 (Methods) 、实现了哪些 trait (Trait implementations) , 以及 Auto trait / Blanket trait 的实现. 可以看到, Bytes 除了实现了刚才讲过的 Buf trait 外, 还实现了很多标准 trait.

所以: 我们自己的数据结构, 也应该尽可能实现需要的标准 trait, 包括但不限于:AsRef、Borrow、Clone、Debug、Default、Deref、Drop、PartialEq/Eq、From、Hash、IntoIterator (如果是个集合类型) 、PartialOrd/Ord 等

4. 深入研究实现逻辑

actix-web

handler 原理

1.1 剖析

在 actix-web 中,路由设置 handler 的方法 定义如下:

#![allow(unused)] fn main() { pub fn to<F, Args>(self, handler: F) -> Self where F: Handler<Args>, Args: FromRequest + 'static, F::Output: Responder + 'static, { self.service = handler_service(handler); self } }

参数handler的约束为Handler<Args>, 其定义如下:

#![allow(unused)] fn main() { pub trait Handler<Args>: Clone + 'static { type Output; type Future: Future<Output = Self::Output>; fn call(&self, args: Args) -> Self::Future; } }

这里的Args就代表n个参数.

结合这两个来看, to函数中Handler<Args>的Args需要实现FromRequest trait 就可以作为参数, 而Handler<Args>的关联类型Output需要实现Responder trait.

但是Args是如何实现动态参数的呢, 来看下to函数的handler_service方法:

#![allow(unused)] fn main() { pub(crate) fn handler_service<F, Args>(handler: F) -> BoxedHttpServiceFactory where F: Handler<Args>, Args: FromRequest, F::Output: Responder, { boxed::factory(fn_service(move |req: ServiceRequest| { let handler = handler.clone(); async move { let (req, mut payload) = req.into_parts(); let res = match Args::from_request(&req, &mut payload).await { Err(err) => HttpResponse::from_error(err), Ok(data) => handler .call(data) .await .respond_to(&req) .map_into_boxed_body(), }; Ok(ServiceResponse::new(req, res)) } })) } }

这里的handler的约束和上而的to区别不大,看下里面的实现,同上面所说Args只需要实现FromRequest就可以拿来做参数, 换句话说, 实现了 FromRequest 你可以在 Handle 方法中的任意参数位置写上你要的参数名和类型.

通过Args::FromRequest提取出参数,就调用handler.call方法执行你的接口, 如何失败则返回FromRequest中定义的Error, 所以你可以随意定义参数提取失败之后返回的内容.

但是问题来了, Args如何实现支持多个参数, 在源码里找到以下定义:

#![allow(unused)] fn main() { macro_rules! tuple_from_req { ($fut: ident; $($T: ident),*) => { /// FromRequest implementation for tuple #[allow(unused_parens)] impl<$($T: FromRequest + 'static),+> FromRequest for ($($T,)+) { type Error = Error; type Future = $fut<$($T),+>; fn from_request(req: &HttpRequest, payload: &mut Payload) -> Self::Future { $fut { $( $T: ExtractFuture::Future { fut: $T::from_request(req, payload) }, )+ } } } pin_project! { pub struct $fut<$($T: FromRequest),+> { $( #[pin] $T: ExtractFuture<$T::Future, $T>, )+ } } impl<$($T: FromRequest),+> Future for $fut<$($T),+> { type Output = Result<($($T,)+), Error>; fn poll(self: Pin<&mut Self>, cx: &mut Context<'_>) -> Poll<Self::Output> { let mut this = self.project(); let mut ready = true; $( match this.$T.as_mut().project() { ExtractProj::Future { fut } => match fut.poll(cx) { Poll::Ready(Ok(output)) => { let _ = this.$T.as_mut().project_replace(ExtractFuture::Done { output }); }, Poll::Ready(Err(e)) => return Poll::Ready(Err(e.into())), Poll::Pending => ready = false, }, ExtractProj::Done { .. } => {}, ExtractProj::Empty => unreachable!("FromRequest polled after finished"), } )+ if ready { Poll::Ready(Ok( ($( match this.$T.project_replace(ExtractFuture::Empty) { ExtractReplaceProj::Done { output } => output, _ => unreachable!("FromRequest polled after finished"), }, )+) )) } else { Poll::Pending } } } }; } impl FromRequest for () { type Error = Infallible; type Future = Ready<Result<Self, Self::Error>>; fn from_request(_: &HttpRequest, _: &mut Payload) -> Self::Future { ok(()) } } tuple_from_req! { TupleFromRequest1; A } tuple_from_req! { TupleFromRequest2; A, B } tuple_from_req! { TupleFromRequest3; A, B, C } tuple_from_req! { TupleFromRequest4; A, B, C, D } tuple_from_req! { TupleFromRequest5; A, B, C, D, E } tuple_from_req! { TupleFromRequest6; A, B, C, D, E, F } tuple_from_req! { TupleFromRequest7; A, B, C, D, E, F, G } tuple_from_req! { TupleFromRequest8; A, B, C, D, E, F, G, H } tuple_from_req! { TupleFromRequest9; A, B, C, D, E, F, G, H, I } tuple_from_req! { TupleFromRequest10; A, B, C, D, E, F, G, H, I, J } tuple_from_req! { TupleFromRequest11; A, B, C, D, E, F, G, H, I, J, K } tuple_from_req! { TupleFromRequest12; A, B, C, D, E, F, G, H, I, J, K, L } }

这里把Args的一堆 tuple, (),A,A, B...都实现了,所以在 handler_service 里的 Args 实际上是一个 tuple,并在里面逐个调用参数的from_request, 接口的参数限制最多12个, 当超过12个参数时就会报错. 这就回答了上面Args支持多个参数.

这里又出新了一个新的问题, 参数解析出来了, 但是 handler.call(data)如何支持多个参数, 看实现, Handler<Args> 给fn各种长度参数fn() -> R, fn(A, B, C) -> R 实现了最多12个参数.

#![allow(unused)] fn main() { /// Generates a [`Handler`] trait impl for N-ary functions where N is specified with a sequence of /// space separated type parameters. /// /// # Examples /// ```ignore /// factory_tuple! {} // implements Handler for types: fn() -> R /// factory_tuple! { A B C } // implements Handler for types: fn(A, B, C) -> R /// ``` macro_rules! factory_tuple ({ $($param:ident)* } => { impl<Func, Fut, $($param,)*> Handler<($($param,)*)> for Func where Func: Fn($($param),*) -> Fut + Clone + 'static, Fut: Future, { type Output = Fut::Output; type Future = Fut; #[inline] #[allow(non_snake_case)] fn call(&self, ($($param,)*): ($($param,)*)) -> Self::Future { (self)($($param,)*) } } }); factory_tuple! {} factory_tuple! { A } factory_tuple! { A B } factory_tuple! { A B C } factory_tuple! { A B C D } factory_tuple! { A B C D E } factory_tuple! { A B C D E F } factory_tuple! { A B C D E F G } factory_tuple! { A B C D E F G H } factory_tuple! { A B C D E F G H I } factory_tuple! { A B C D E F G H I J } factory_tuple! { A B C D E F G H I J K } factory_tuple! { A B C D E F G H I J K L } }

1.2 总结

rust日记

你应知道的crate

基础库

- overload Simplified operator overloading in Rust

- enum-iterator Tools to iterate over all values of a type

- cfg-if A if/elif-like macro for Rust #[cfg] statements

- arrayref Two macros for taking array references in rust.

- Educe This crate provides procedural macros to help you implement Rust-built-in traits quickly.

- rust-derivative A set of alternative

deriveattributes for Rust - tap Generic extensions for tapping values in Rust.

- strum A small rust library for adding custom derives to enums.

- derive_more Some more derive(Trait) options.

- rust-derive-builderderive builder implementation for rust structs.

- enum_dispatch Near drop-in replacement for dynamic-dispatched method calls with up to 10x the speed.

- paste Macros for all your token pasting needs.

- num A collection of numeric types and traits for Rust.

- either The enum Either with variants Left and Right is a general purpose sum type with two cases.

- thiserror derive(Error) for struct and enum error types.

- rayon A data parallelism library for Rust.

- Crossbeam About Tools for concurrent programming in Rust.

- async_trait Type erasure for async trait methods.

- fs-err A simple wrapper around filesystem operations to provide more helpful error messages.

- tempfile Temporary file library for rust.

- bincode A binary encoder / decoder implementation in Rust.

- maplit Rust container / collection literal macros for HashMap, HashSet, BTreeMap, BTreeSet.

- indexmap A hash table with consistent order and fast iteration; access items by key or sequence index.

不可变数据建议Rc<[T]>/Arc<[T]>替代Vec<[T]>

slice 对于不可变数据, Arc<[T]>可能是比 Vec<T> 更好的选择, 因此, 如果你在构建一个大数据序列, 并且

之后不会修改, 那么考虑 Rc<[T]>, 它非常适合存储的数据或数组或集合或只是传递一般引用.

看下内存模型就明白了:

#![allow(unused)] fn main() { stack [ptr |meta] +–––-+–––+ │ * │ │ +–│-–+--–│ | heap | +–V–+–––+–––+ │ │ │ T │ +–––+--–+–––+ / │ ref count <–/ V weak ref count }

(译)Rust临时生命周期和"Super Let"1

在Rust中, 临时变量生命周期是一个复杂但又经常被忽视的话题. 在一些简单的情况下, Rust会让临时变量存活足够长的时间, 这样我们就不必考虑它们了. 然而, 在很多情况下, 我们可能无法立即得到我们想要的东西.

在这篇文章中, 我们将(重新)发掘临时变量生命周期的规则, 介绍一些临时生命周期扩展的用例, 并探索一种新的语言理念--super let,, 为我们提供更多控制.

临时变量

下面是一条Rust语句, 没有上下文, 使用的是临时String:

#![allow(unused)] fn main() { f(&String::from('🦀')); }

这个临时String的存活时间多长?如果我们今天设计Rust, 基本上有两种选择:

- 在调用

f之前, 字符串会被立即丢弃. 或者 - 只有在调用

f后, 字符串才会被丢弃.

如果我们选择方案1, 那么上面的语句将始终导致借用检查错误, 因为我们不能让f借用已经消失的东西.

因此, Rust选择了方案2: 首先分配字符串, 然后将其引用传递给f, 只有在f返回后, 我们才会丢弃临时字符串.

在一个 let 语句中

现在是一个稍难的问题:

#![allow(unused)] fn main() { let a = f(&String::from('🦀')); … g(&a); }

再来: 这个临时String的存活时间多长?

- 字符串会在

let语句结束时丢弃: 即在f返回之后, 但在g被调用之前. 或者 - 字符串会在调用

g之后的同时a被丢弃.

如果f被定义为 fn f(s: &str) -> usize(如str::len), 那么在let语句后立即去掉String就完全没问题了.

但是, 如果f被定义为 fn f(s: &str) -> &[u8](就像 str::as_bytes), 那么 a 就会从临时变量 String 中借用, 因此如果我们将a保留较长时间, 就会出现借用检查错误.

如果采用方案2, 在这两种情况下都能正常编译, 但我们可能会在超出必要的存活时间内保留一个临时变量, 这可能会浪费资源或导致微妙的错误(例如, 当MutexGuard比预期时间晚丢弃时会造成死锁).

这听起来像是第3种选择: 让它取决于f的签名.

但是, Rust的借用检查器只执行检查, 并不影响代码的行为. 出于各种原因, 这是一个非常重要和有用的属性. 举例来说, 将 fn f(s:&str)->&[u8](返回值借用参数)改为 fn f(s:&str)->&'static[u8](返回值不借用参数)并不会改变调用位置的任何内容, 例如临时变量被丢弃的位置.

因此, 在方案1和方案2之间, Rust选择了方案1: 在let语句末尾删除临时变量. 很容易手动将String移到单独的let语句中, 让它保持更长的时间.

#![allow(unused)] fn main() { let s = String::from('🦀'); // Moved to its own `let` to give it a longer lifetime. let a = f(&s); … g(&a); }

在嵌套调用中

好吧, 再来一个:

#![allow(unused)] fn main() { g(f(&String::from('🦀'))); }

同样, 有两种选择:

- 在调用

f之后、调用g之前, 字符串被丢弃. 或者 - 字符串会在语句结束时丢弃, 所以是在调用

g之后.

该代码段与前一个代码段几乎完全相同: 临时String的引用被传递给f, f的返回值被传递给g.

不过, 方案1可能有效, 也可能无效, 这取决于f的签名, 而方案2可能会让临时变量存活更长的时间.

不过, 这次方案1会给程序员带来更多惊喜. 例如, 即使是简单的 String::from('🦀').as_bytes().contains(&0x80) 也无法编译, 因为字符串会在 as_bytes(f) 之后、contains (g) 之前被删除.

也可以说, 把临时变量多存活一段时间的坏处要小得多, 因为他们在声明结束时仍然会被丢弃.

因此, Rust选择了方案2: 无论f的签名如何, 字符串都会一直存在, 直到语句结束, 直到g被调用.

在一个 if 语句中

现在, 我们来看看简单的 if 语句:

#![allow(unused)] fn main() { if f(&String::from('🦀')) { … } }

同样的问题: String 何时丢弃?

- 在

if的条件求值之后, 但在if的主体执行之前(即在{处). 或者 - 在

if主体执行之后(即在}处).

在这种情况下, 就没有理由在if主体中保留临时值. 条件的结果是一个布尔值(只有true或false), 顾名思义, 这并不借用任何东西.

因此, Rust选择方案1.

例如, 在使用 Mutex::lock 时, 它就会返回一个临时MutexGuard, 当Mutex被丢弃时, 它就会解锁:

#![allow(unused)] fn main() { fn example(m: &Mutex<String>) { if m.lock().unwrap().is_empty() { println!("the string is empty!"); } } }

在这里, m.lock().unwrap()中的临时MutexGuard会在.is_empty()之后丢弃, 这样Mutex就不会在println语句中被不必要地锁定.

在 if let 语句中

但 if let(和 match)的情况有所不同, 因为此时我们的表达式并不一定是评估布尔值:

#![allow(unused)] fn main() { if let … = f(&String::from('🦀')) { … } }

再次, 有两种选择:

- 在模式匹配之后、

if let的正文之前(即{处)删除字符串. 或者、 - 在

if let主体之后(即}处)删除字符串.

这一次, 我们有理由选择方案2而不是方案1, 在if let语句或match中借用模式是很常见的.

因此, 在这种情况下, Rust选择了方案2.

例如, 如果我们有一个Mutex<Vec<T>>类型的vec, 编译起来就很好:

#![allow(unused)] fn main() { if let Some(x) = vec.lock().unwrap().first() { // The mutex is still locked here. :) // This is necessary, because we're borrowing `x` from the `Vec`. (`x` is a `&T`) println!("first item in vec: {x}"); } }

我们从m.lock().unwrap()获得一个临时的MutexGuard, 并使用.first()方法借用第一个元素. 由于MutexGuard只在最后一个 }才被丢弃, 因此借用将持续整个if let主体.

不过, 在有些情况下, 这并不是我们想要的. 例如, 如果我们使用pop代替first, 它返回的是值而不是引用:

#![allow(unused)] fn main() { if let Some(x) = vec.lock().unwrap().pop() { // The mutex is still locked here. :( // This is unnecessary, because we don't borrow anything from the `Vec`. (`x` is a `T`) println!("popped item from the vec: {x}"); } }

这可能会令人惊讶, 并导致微妙的错误或性能降低.

也许这就是Rust选择错误方案的一个论据, 也许这就是在未来版本的Rust中改变这一规则的一个论据. 关于如何修改这些规则的想法, 请参阅 Niko’s blog post on this topic.

目前, 解决方法是使用一个单独的let 语句, 将临时生命周期限制在该语句中:

#![allow(unused)] fn main() { let x = vec.lock().unwrap().pop(); // The MutexGuard is dropped after this statement. if let Some(x) = x { … } }

临时生命周期扩展

这种情况如何?

#![allow(unused)] fn main() { let a = &String::from('🦀'); … f(&a); }

两种选择:

- 字符串会在

let语句的末尾被丢弃. 或者 - 在调用

f后, 字符串与a同时被删除.

方案1 总是会导致借用检查错误. 因此, 方案2可能更有意义. 如今Rust也确实是这样工作的: 临时生命周期被扩展了, 因此上面的代码段可以正常编译.

这种临时变量生命周期长于它在声明中出现的时间的现象被称为临时生命周期扩展.

临时生命周期扩展并不适用于所有出现在let语句中的临时字符串, 正如我们已经看到的那样: let a = f(&String::from('🦀')); 中的临时字符串不会超过 let语句的生命周期.

在let a = &f(&String::from('🦀'));(注意多出的 &)中, 临时生命周期扩展确实适用于最外层的&, 它借用了作为f 返回值的临时, 但不适用于内层的&, 它借用了String.

例如, 用str::len 代替f:

#![allow(unused)] fn main() { let a: &usize = &String::from('a').len(); }

在这里, 字符串在 let 语句的末尾被删除, 但 .len()返回的usize和a活的一样长.

这不仅限于 let _ = &...; 语法. 例如

#![allow(unused)] fn main() { let a = Person { name: &String::from('🦀'), // Extended! address: &String::from('🦀'), // Extended! }; }

在上面的代码段中, 临时字符串的生命周期将被扩展, 因为即使我们对 Person 类型一无所知, 我们也可以肯定, 生命周期扩展对于生成对象之后的可用性是必要的.

关于 let 语句中哪些临时变量的生命周期会被延长, temporary lifetime extension in Rust Reference中有详细的说明, 但实际上只适用于那些从语法上就能看出有必要延长生命周期的表达式, 而与任何类型、函数签名或特质实现无关:

#![allow(unused)] fn main() { let a = &temporary().field; // Extended! let a = MyStruct { field: &temporary() }; // Extended! let a = &MyStruct { field: &temporary() }; // Both extended! let a = [&temporary()]; // Extended! let a = { …; &temporary() }; // Extended! let a = f(&temporary()); // Not extended, because it might not be necessary. let a = temporary().f(); // Not extended, because it might not be necessary. let a = temporary() + temporary(); // Not extended, because it might not be necessary. }

虽然这看起来很合理, 但当我们考虑到构造元组结构或元组变体的语法只是一个函数调用时, 确实会感到意外: 从语法上讲, Some(123) 是对函数 Some 的函数调用.

例如:

#![allow(unused)] fn main() { let a = Some(&temporary()); // Not extended! (Because `Some` could have any signature...) let a = Some { 0: &temporary() }; // Extended! (I bet you have never used this syntax.) }

这可能会让人相当困惑.

这也是值得考虑重新修订规则的原因之一.

持续推广

临时生命周期扩展很容易与另一种叫不断晋升的东西混淆, 后者是临时变量获得比预期生命周期长的另一种方式.

在&123和&None这样的表达式中, 值被认定为常量(without interior mutability and without desctructors), 因此会自动晋升为永生值. 这意味着这些引用将具有'static生命周期.

例如:

#![allow(unused)] fn main() { let x = f(&3); // The &3 here is 'static, regardless if that's necessary for `f()`. }

This even applies to simple expressions:

#![allow(unused)] fn main() { let x = f(&(1 + 2)); // The &3 here is 'static. }

在同时适用临时生命周期延长和恒定提升的情况下, 后者优先, 因为它延长的生命周期最长:

#![allow(unused)] fn main() { let x = &1; // constant promotion, not temporary lifetime extension. }

也就是说, 在上面的代码段中, x是一个'static引用. 值1的寿命甚至比x本身还长.

代码块中的临时生命周期扩展

想象一下, 我们有某种Writer类型, 它持有一个要写入的文件的引用:

#![allow(unused)] fn main() { pub struct Writer<'a> { pub file: &'a File } }

以下代码创建了Writer, 写入新创建的文件:

#![allow(unused)] fn main() { println!("opening file..."); let filename = "hello.txt"; let file = File::create(filename).unwrap(); let writer = Writer { file: &file }; }

现在的作用域包含filename、file和writer. 然而, 后面的代码只能通过

Writer写入. 理想的情况是, 在作用域中已经看不到filename, 尤其是file.

由于临时生命周期扩展也适用于代码块的最终表达式, 因此我们可以通过以下方式来实现:

#![allow(unused)] fn main() { let writer = { println!("opening file..."); let filename = "hello.txt"; Writer { file: &File::create(filename).unwrap() } }; }

现在, Writer的创建被整齐地封装在它自己的作用域中, 这样外层作用域只能看到 writer, 而看不到其他任何东西.得益于临时生命周期的扩展, 在内作用域中作为临时创建的file与 writer 一样的存活时间.

临时生命周期扩展的限制

试想一下, 如果我们将Writer结构中的file字段设置为私有, 会是怎样的结果?

#![allow(unused)] fn main() { pub struct Writer<'a> { file: &'a File } impl<'a> Writer<'a> { pub fn new(file: &'a File) -> Self { Self { file } } } }

这样, 我们就不需要对原始用法片段做太多改动了:

#![allow(unused)] fn main() { println!("opening file..."); let filename = "hello.txt"; let file = File::create(filename).unwrap(); let writer = Writer::new(&file); // Only this line changed. }

我们只需调用Writer::new()而不是使用Writer {}语法来构建.

不过, 这对作用域版本无效:

#![allow(unused)] fn main() { let writer = { println!("opening file..."); let filename = "hello.txt"; Writer::new(&File::create(filename).unwrap()) // Error: Does not live long enough! }; writer.something(); // Error: File no longer alive here! }

正如我们之前看到的, 虽然临时生命周期扩展会通过Writer {}结构语法传播, 但不会通过Writer::new()函数调用语法传播. (例如, 签名可以是fn new(&File) -> Self<'static>或fn new(&File) -> i32, 这样就不需要扩展临时生命周期了).

遗憾的是, 我们无法明确选择临时生命周期扩展.我们必须在最外层作用域中设置一个let file.目前我们能做的最好的办法就是使用延迟初始化:

#![allow(unused)] fn main() { let file; let writer = { println!("opening file..."); let filename = "hello.txt"; file = File::create(filename).unwrap(); Writer::new(&file) }; }

但这会使file回到作用域中, 而这正是我们想要避免的.

虽然可以说把let file放在作用域外部并不是什么大问题, 但对于大多数Rust程序员来说, 这种变通方法并不明显.延迟初始化并不是一个常用的功能, 编译器目前在给出临时生命周期错误时也不会建议采用这种变通方法. 即使编译器可以这样做, 这也不是一个小改动.

如果能以某种方式解决这个问题就好了

Macros宏

如果有一个函数既能创建文件, 又能返回一个 Writer 文件, 可能会很有用.比如

#![allow(unused)] fn main() { let writer = Writer::new_file("hello.txt"); }

但是, 由于 Writer 只借用file, 这就要求 new_file 将File存储在某个地方.它可以leak这个File或以某种方式将其存储在static中, 但(目前)它没有办法让file与返回的 Writer 一样长存.

因此, 我们可以使用宏来定义文件和写入器, 无论它在哪里被调用:

#![allow(unused)] fn main() { macro_rules! let_writer_to_file { ($writer:ident, $filename:expr) => { let file = std::fs::File::create($filename).unwrap(); let $writer = Writer::new(&file); }; } }

使用方法如下:

#![allow(unused)] fn main() { let_writer_to_file!(writer, "hello.txt"); writer.something(); }

由于宏的卫生性, 在此范围内无法访问file.

这样做是可行的, 但如果它看起来更像一个普通的函数调用, 不是更好吗?

#![allow(unused)] fn main() { et writer = writer_to_file!("hello.txt"); writer.something(); }

正如我们之前所见, 在 let writer = ...;语句中创建一个存活时间足够长的临时File的方法是使用临时生命周期扩展:

#![allow(unused)] fn main() { macro_rules! writer_to_file { ($filename:expr) => { Writer { file: &File::create($filename).unwrap() } }; } let writer = writer_to_file!("hello.txt"); }

这将扩展成:

#![allow(unused)] fn main() { let writer = Writer { file: &File::create("hello.txt").unwrap() }; }

这将在必要时延长临时File的生命周期.

但如果file不是公开, 我们就不能这样做, 而需要使用 Writer::new() 代替.宏需要在调用它的 let writer = ...;语句之前插入 let file;.这是不可能的.

format_args!()

这个问题也是(现在)format_args!() 的结果不能存储在 let 语句中的原因:

#![allow(unused)] fn main() { let f = format_args!("{}", 1); // Error! something.write_fmt(f); }

原因是 format_args!() 会扩展为类似 fmt::Arguments::new(&Argument::display(&arg), ...) 的内容, 其中一些参数是对临时变量的引用.

临时生命周期扩展不适用于函数调用的参数, 因此 fmt::Arguments 对象只能在同一语句中使用.

pin!()

另一种经常通过宏创建的类型是 Pin.粗略地说, 它表示对某个永远不会移动的东西的引用.(具体细节很复杂, 但现在不是很重要).

它是通过一个名为 Pin::new_unchecked 的unsafe函数创建的, 因为我们需要保证它所引用的值即使在 Pin 本身消失后也不会被移动.

使用该函数的最佳方法是使用shadowing:

#![allow(unused)] fn main() { let mut thing = Thing { … }; let thing = unsafe { Pin::new_unchecked(&mut thing) }; }

因为第二个thing会对第一个thing产生shadow, 所以第一个thing(仍然存在)不能再被命名.因为它不能被命名, 所以我们可以确定它不能被移动(即使在放弃第二个thing后), 这正是我们在unsafe块中所承诺的.

因为这是一种常见的模式, 所以通常用宏来捕获这种模式.

例如, 我们可以定义一个 let_pin 宏如下:

#![allow(unused)] fn main() { macro_rules! let_pin { ($name:ident, $init:expr) => { let mut $name = $init; let $name = unsafe { Pin::new_unchecked(&mut $name) }; }; } }

使用方法与之前的 let_writer_to_file 宏类似:

#![allow(unused)] fn main() { let_pin!(thing, Thing { … }); thing.something(); }

这样做可以很好地封装和隐藏不安全代码.

但是, 就像我们的 Writer 示例一样, 如果它能像下面这样工作, 不是更好吗?

#![allow(unused)] fn main() { let thing = pin!(Thing { … }); }

我们都知道, 要做到这一点, 我们必须利用临时生命周期扩展功能, 使Thing的生命周期足够长.而要做到这一点, 我们必须使用 Pin {} 语法来构造 Pin:Pin { pinned: &mut Thing { ... }} 会调用临时生命周期扩展, 但 Pin::new_unchecked(&mut Thing { ... }) 不会.

这就意味着要将 Pin 的字段公开, 这就违背了 Pin 的初衷.只有在字段是私有的情况下, 它才能提供有意义的保证.

这意味着, 不幸的是, (如今)不可能自己编写这样一个 pin!() 宏.

标准库还是这么做了, 犯了一个可怕的罪行:Pin 的 "私有 "字段实际上被定义为 pub, 但也被标记为 "不稳定", 如果你试图使用它, 编译器就会抱怨.

如果不需要这种黑客手段就好了.

super let

用户体验和诊断

可能的扩展

未来可能的扩展是允许在函数作用域中使用super let. 也就是说, "super"指的是函数的调用者.

正如@lorepozo@tech.lgbt在Mastodon上提到的, 这将使 pin!() 成为一个函数而不是宏. 同样, 它也能让 Writer::new_file(...) 成为可能, 而不必使用宏.

这样做的有效方式是允许某些函数将对象放入调用者的堆栈框架中, 然后可以从返回值中引用这些对象. 这在任何普通的旧函数中都是行不通的;通常情况下, 调用者不会为函数预留放置对象的空间. 这需要成为函数签名的一部分.

也许可以这样?

#![allow(unused)] fn main() { pub placing fn new_file(filename: &str) -> Writer { super let mut file = File::create(filename).unwrap(); // Placed into caller's stack frame Writer::new(&file) // So we can borrow it in the return value! } }

这不是我现在提出的建议的一部分, 但想想也很有趣. )

临时生命周期 2024 RFC

几个月前, 我与Niko Matsakis和Ding Xiang Fei分享了我的想法--super let.他们一直在努力制定super let的确切定义和详细规则, 以及下一版Rust的临时生命周期的一些新规则.

这项名为 “temporary lifetimes 2024” effort的联合工作正在促成一项RFC, 该RFC主要建议尽可能减少临时生命周期, 以防止 if let 或匹配中的临时 MutexGuard 导致的死锁, 并添加 super let 作为选择更长生命周期的一种方式.

反馈

你是否有意识地使用过临时延长寿命的方法?或者你被它咬过吗?

你怎么看super let?你会使用它吗?或者你有更好的主意?

请在下面的评论或 GitHub 上告诉我, 或加入 Reddit``、Twitter 或 Mastodon 上的讨论.

引用

宏系统

声明宏

过程宏

| 类别 | 形式 | 函数名称 | 函数签名 |

|---|---|---|---|

| 函数式 | #[paoc_macro] | 函数名即宏名 | (TokenStream) -> TokenStream |

| 属性式 | #[proc_macro_attribute] | 函数名即宏名 | (TokenStream, TokenStream) -> TokenStream |

derive式 | #[proc_macro_derive(Name)]或者#[proc_macro_derive(Name, attributes(attr))] | 任意,因为宏名是Name | (TokenStream) -> TokenStream |

proc-macro crate

定义一个过程宏crate的方式是将在crate type设为proc-macro.

当使用Cargo时, 过程宏crate是将Cargo.toml中的lib.proc-macro设为true值.

[lib]

proc-macro = true

它只能导出过程宏, 正常的函数、类型、模块、macro_rules! 等内容都不能导出, 但可以仅在其内部定义和使用.

函数式过程宏

类型函数的过程宏, 像声明宏那样被调用, 即makro!(...). 它是唯一一个在单独看调用形式时, 无法与声明宏区分开的宏.

函数式过程宏的简单编写框架如下所示:

#![allow(unused)] fn main() { use proc_macro::TokenStream; #[proc_macro] pub fn fn_name_macro(input: TokenStream) -> TokenStream { input } }

可以看到, 这实际上只是从一个TokenStream到另一个TokenStream的映射, 其中 input 是调用分隔符内的标记.

属性式过程宏

属性式过程宏定义了可添加到条目的的新外部属性.这种宏通过 #[attr] 或 #[attr(…)] 方式调用, 其中 … 是任意标记树.

属性式过程宏的简单框架如下所示:

#![allow(unused)] fn main() { use proc_macro::TokenStream; #[proc_macro_attribute] pub fn attribute_name_macro(input: TokenStream, annotated_item: TokenStream) -> TokenStream { annotated_item } }

需要注意的是, 与其它两个过程宏不同, 这种宏有两个输入参数.

- 第一个参数是属性名称后面的带分隔符的标记树, 不包括它周围的分隔符.如果只有属性名称(其后不带标记树, 比如

#[attr]), 则这个参数的值为空. - 第二个参数是添加了该过程宏属性的条目, 但不包括该过程宏所定义的属性.因为这是一个

active属性, 在传递给过程宏之前, 该属性将从条目中剥离出来.

derive式过程宏

derive式过程宏为derive属性定义了新的输入.这种宏通过将其名称提供给derive属性的输入来调用, 例如 #[derive(derive_name)].

derive式过程宏的简单框架如下所示:

#![allow(unused)] fn main() { use proc_macro::TokenStream; #[proc_macro_derive(derive_name)] pub fn derive_name_macro(input: TokenStream) -> TokenStream { TokenStream::new() } }

proc_macro_derive稍微特殊一些, 因为它需要一个额外的标识符, 此标识符将成为 derive 宏的实际名称.

输入标记流是添加了 derive 属性的条目, 也就是说, 它将始终是 enum、struct 或者 union 类型, 因为这些是 derive 属性仅可以添加上去的条目.

输出的标记流将被追加到带注释的条目所处的块或模块, 所以要求标记流由一组有效条目组成.

属性宏与

derive宏的显著区别在于, 属性宏生成的标记是完全替换性质, 而derive宏生成的标记是追加性质.

derive式过程宏的辅助属性

derive 宏又有一点特殊, 因为它可以添加仅在条目定义范围内可见的附加属性.

这些属性被称为派生宏辅助属性(derive macro helper attributes), 并且是惰性的(inert).

辅助属性的目的是在每个结构体字段或枚举体成员的基础上为 derive 宏提供额外的可定制性.

辅助属性的定义方式是向 proc_macro_derive 属性增加 attributes(helper0, helper1, ..) 参数, 该参数可包含用逗号分隔的标识符列表(即辅助属性的名称).

编写带辅助属性的`derive``宏的简单框架如下所示:

#![allow(unused)] fn main() { use proc_macro::TokenStream; #[proc_macro_derive(derive_name, attributes(helper0, helper1, ...))] pub fn derive_name_macro(input: TokenStream) -> TokenStream { TokenStream::new() } }

这就是辅助属性的全部内容.在过程宏中使用(或者说消耗)辅助属性, 得检查字段和成员的属性, 来判断它们是否具有相应的辅助属性 如果条目使用了所有 derive 宏都未定义的辅助属性, 那么会出现错误, 因为编译器会尝试将这个辅助属性解析为普通属性(而且这个属性并不存在).

Reference

rust交叉编译

toolchain和target分别是, toolchain是交叉编译所需的“编译工具”, 而target则是编译到目标平台所需的"库文件"

什么是 Toolchain

toolchain 指一组Rust工具, 包括编译器(rustc), 构建工具(cargo), 文档生成工具(rustdoc)以及其他与 Rust 相关的实用程序. Toolchain用于管理和构建 Rust 代码, 并且可以包括一个特定版本的 Rust 编译器和标准库, 还包含一个默认是编译到本机平台的target. 工具链的版本可以是 "stable"(稳定版), "beta"(测试版)或 "nightly"(每日构建版), 每个版本都对应着不同的 Rust 编译器和特性. 工具链中的工具命令了, 它们通常存储在~/.cargo/bin这个目录下.

什么是 Rustc target

Rust 中的target概念主要是为了支持跨平台开发和交叉编译, 以确保 Rust 代码可以在不同的操作系统和架构上正确运行. Rustc target指的是编译和构建目标平台Rust代码时需要的组件. 不要混淆为Rust项目编译后产生的target文件夹. 它的格式表示为: <arch>-<vendor>-<os>-<abi>. 其中:

<arch>表示架构(例如, x86_64 表示64位的x86架构).<vendor>表示供应商(一般为空).<os>表示操作系统(例如, linux, windows, macos 等).<abi>表示二进制接口(例如, 默认的是 "gnu", 也可以是 "musl", "msvc" 等)

例如:

x86_64-unknown-linux-gnu: 64位 x86 架构, Linux 操作系统, 使用 gnu.x86_64-unknown-linux-musl64位 x86 架构, Linux 操作系统, 使用 musl.i686-pc-windows-msvc: 32位 x86 架构, Windows 操作系统, 使用 MSVC 编译器.

一般来说只需要rustup target add <target>命令安装某个目标平台组件即可, 但对于一些特殊平台, 可能需要手动安装相关的交叉编译工具链, 例如windows msvc或者android NDK.

常用命令:

# 列出可用的target

rustup target list

# 安装一个新的rustup target add <target>

rustup target add x86_64-unknown-linux-gnu

# 把代码编译到指定平台

cargo build --target x86_64-unknown-linux-gnu

Rust编译流程

Source code -> MIR -> LLVM IR -> 机器码 -> Target链接 -> 可执行文件或库

以Linux平台为例, Rust编译器就是rustc

- 首先会把源码编译为

MIR - 然后交给

LLVM处理,LLVM继续把MIR先编译成LLVM IR. - 进而编译为目标平台的机器码(此时还不是执行文件, 只是一堆机器码)

- 往后就是

target发挥作用了,target调用msvc或gnu来完成链接步骤, 主要是链接目标平台库文件并生成可执行文件.

这里整个编译过程几乎都是由rustc完成的, 因为它包含了llvm和调用target的代码, 跟目标平台相关的工作则是由msvc或gnu来完成. msvc和gnu是c/c++的编译工具链, 编译后的最终产物就是可执行文件或库, rustc在编译后期用到了它们提供的功能.

交叉编译

Ubuntu默认的target是gnu的, 依赖glibc, 但是其他Linux系统未必是glibc是基础库, 但是可以用同一套toolchain(编译器之类的), 因此只需要添加target即可.

而交叉编译到Windows, 则Linux的编译器是没有这个能力的, 因此需要添加Windows平台的toolchain(有部分toolchain官方没有实现还得添加第三方的toolchain), 然后再添加target.

注意, 如果Windows选择的是msvc而非gnu, 那么哪怕是最简单的hello world也必须要安装visual studio(主要是需要它携带的toolchain[linker等])

References

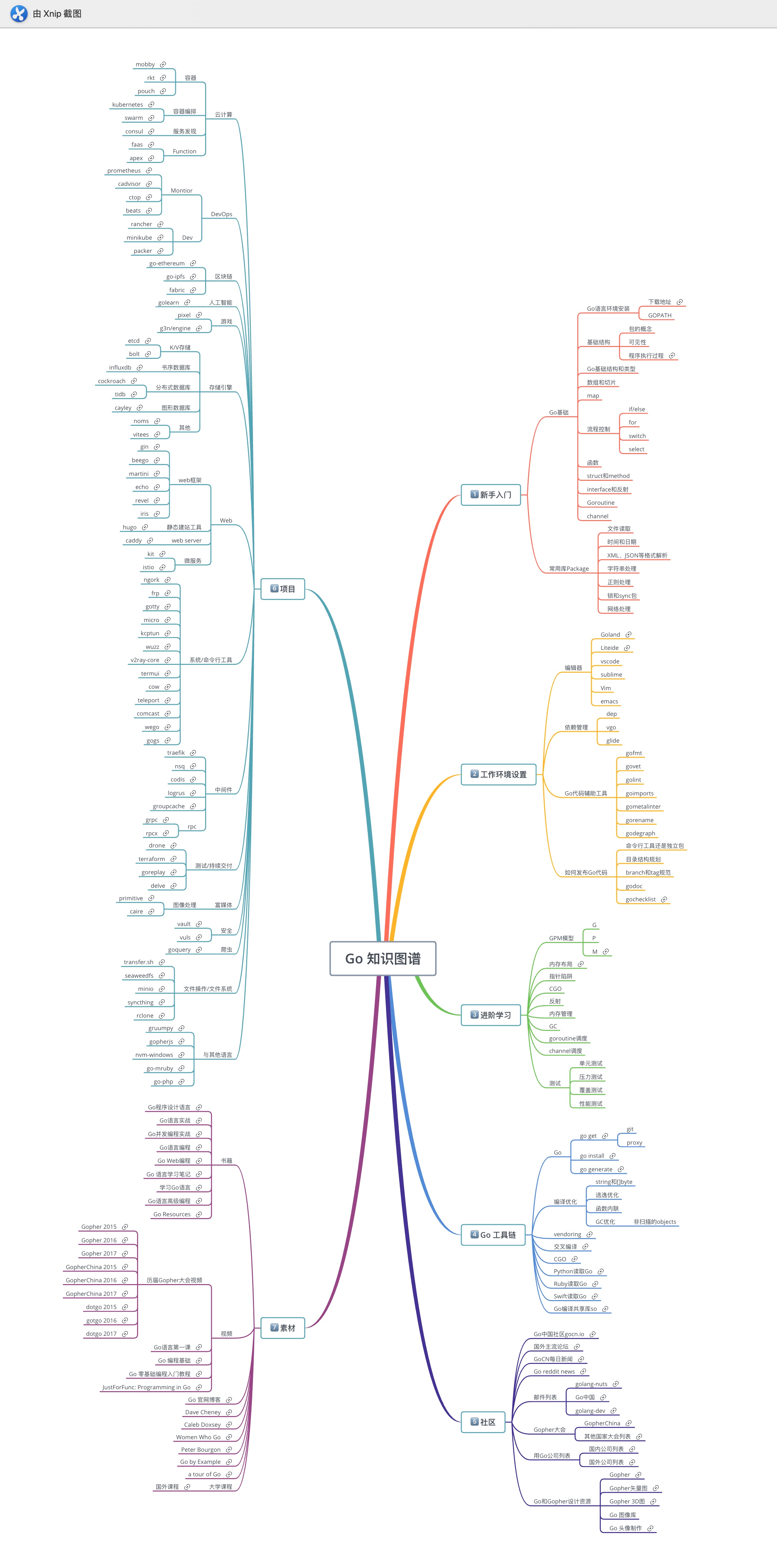

Golang

Golang AST

1. Token

Token是编程语言中最小的具有独立含义的词法单元.

Token不仅仅包含关键字,还包含用户自定义的标识符、运算符、分隔符和注释等.

每个Token对应的词法单元有三个属性是比较重要的:

- Token本身的值表示词法单元的类型

- Token在源代码中源代码文本形式

- Token出现的位置

- 在所有的Token中,注释和分号是两种比较特殊的Token:

- 普通的注释一般不影响程序的语义,因此很多时候可以忽略注释;

- Go语言中经常在行尾自动添加分号Token,而分号是分隔语句的词法单元,因此自动添加分号导致了Go语言左花括弧不能单独一行等细微的语法差异.

1.1 Token语法

Go语言中主要有标识符、关键字、运算符和分隔符等类型等Token组成.

- 标识符由字母和数字组成,开头第一个字符必须是字母,标识符的语法定义如下:

identifier = letter { letter | unicode_digit } .

letter = unicode_letter | "_" .

- 关键字用于引导特殊的语法结构,不能将关键字作为独立的标识符.下面是Go语言定义的25个关键字:

break default func interface select

case defer go map struct

chan else goto package switch

const fallthrough if range type

continue for import return var

- 运算符和分隔符,下面是Go语言定义的47个符号:

+ & += &= && == != ( )

- | -= |= || < <= [ ]

* ^ *= ^= <- > >= { }

/ << /= <<= ++ = := , ;

% >> %= >>= -- ! ... . :

&^ &^=

用户自定义的标识符、25个关键字、47个运算和分隔符号,程序中还有一些面值、注释和空白符组成

1.2 Token定义

在go/token包中,Token被定义为一种枚举值,不同值的Token表示不同类型的词法记号:

// Token is the set of lexical tokens of the Go programming language.

type Token int

// The list of tokens.

const (

// Special tokens

ILLEGAL Token = iota

EOF

COMMENT

literal_beg

// Identifiers and basic type literals

// (these tokens stand for classes of literals)

IDENT // main

INT // 12345

FLOAT // 123.45

IMAG // 123.45i

CHAR // 'a'

STRING // "abc"

literal_end

operator_beg

// Operators and delimiters

ADD // +

SUB // -

MUL // *

QUO // /

REM // %

AND // &

OR // |

XOR // ^

SHL // <<

SHR // >>

AND_NOT // &^

ADD_ASSIGN // +=

SUB_ASSIGN // -=

MUL_ASSIGN // *=

QUO_ASSIGN // /=

REM_ASSIGN // %=

AND_ASSIGN // &=

OR_ASSIGN // |=

XOR_ASSIGN // ^=

SHL_ASSIGN // <<=

SHR_ASSIGN // >>=

AND_NOT_ASSIGN // &^=

LAND // &&

LOR // ||

ARROW // <-

INC // ++

DEC // --

EQL // ==

LSS // <

GTR // >

ASSIGN // =

NOT // !

NEQ // !=

LEQ // <=

GEQ // >=

DEFINE // :=

ELLIPSIS // ...

LPAREN // (

LBRACK // [

LBRACE // {

COMMA // ,

PERIOD // .

RPAREN // )

RBRACK // ]

RBRACE // }

SEMICOLON // ;

COLON // :

operator_end

keyword_beg

// Keywords

BREAK

CASE

CHAN

CONST

CONTINUE

DEFAULT

DEFER

ELSE

FALLTHROUGH

FOR

FUNC

GO

GOTO

IF

IMPORT

INTERFACE

MAP

PACKAGE

RANGE

RETURN

SELECT

STRUCT

SWITCH

TYPE

VAR

keyword_end

)

所有的Token被分为四类:特殊类型、基础面值、运算符(分隔符)和关键字.

- 特殊类型的Token.

有错误、文件结束和注释三种,遇到不能识别的Token统一返回ILLEGAL,这样可以简化词法分析时的错误处理.

- 基础面值对应的Token

Go语言规范定义的基础面值主要有整数、浮点数和复数面值类型,此外还有字符和字符串面值类型.

需要注意的是,在Go语言规范中布尔类型的true和false并不在基础面值之类.但是为了方便词法解析,go/token包将true和false等对应的标识符也作为面值Token一类.其中literal_beg和literal_end是私有的类型,主要用于表示面值类型Token的值域范围

- **运算符(分隔符)**Token

运算符主要有普通的加减乘除等算术运算符号,此外还有逻辑运算、位运算符和比较运算等二元运算(其中二元运算还和赋值运算再次组合).

除了二元运算之外,还有少量的一元运算符号:比如正负号、取地址符号、管道的读取等.而分隔符主要是小括弧、中括弧、大括弧,以及逗号、点号、分号和冒号组成.

- 关键字Token

从词法分析角度看,关键字和普通的标识符并无差别.但是25个关键字一般都是不同语法结构的开头Token,通过将这些特殊的Token定义为关键字可以简化语法解析的工作

1.3 FileSet和File

go/token包还定义了FileSet和File对象,用于描述文件集和文件.

FileSet和File对象的对应关系如图所示:

每个

FileSet表示一个文件集合,底层抽象为一个一维数组,而Pos类型表示数组的下标位置.FileSet中的每个File元素对应底层数组的一个区间,不同的File之间没有交集,相邻的File之间可能存在填充空间.

每个File主要由文件名、base和size三个信息组成. 其中base对应File在FileSet中的Pos索引位置,因此base和base+size定义了File在FileSet数组中的开始和结束位置. 在每个File内部可以通过offset定位下标索引,通过offset+File.base可以将File内部的offset转换为Pos位置.因为Pos是FileSet的全局偏移量,反之也可以通过Pos查询对应的File,以及对应File内部的offset.

词法分析的每个Token位置信息就是由Pos定义,通过Pos和对应的FileSet可以轻松查询到对应的File.然后在通过File对应的源文件和offset计算出对应的行号和列号(实现中File只是保存了每行的开始位置,并没有包含原始的源代码数据). Pos底层是int类型,它和指针的语义类似,因此0也类似空指针被定义为NoPos,表示无效的Pos.

1.4 解析Token

Go语言标准库go/scanner包提供了Scanner实现Token扫描,它是在FileSet和File抽象文件集合基础上进行词法分析.

scanner.Scanner的公开接口定义如下

type Scanner struct {

// public state - ok to modify

ErrorCount int // number of errors encountered

// Has unexported fields.

}

func (s *Scanner) Init(file *token.File, src []byte,err ErrorHandler, mode Mode)

func (s *Scanner) Scan() (pos token.Pos, tok token.Token, lit string)

Init方法用于初始化扫描器:file参数表示当前的文件(不包含代码数据)src参数表示要分析的代码err是用户自定义的错误处理函数mode可以控制是否扫描注释部分

Scan方法扫描一个Token,三个返回值分别表示:

pos表示Token的位置tok表示Token值lit表示Token的源代码文本表示

package main

import (

"fmt"

"go/scanner"

"go/token"

)

// 要构造一个最简单的词法扫描器测试程序,首先要构造Init方法第一参数需要的File对象.但是File对象没有公开的构造函数,只能通过FileSet的AddFile方法间接构造File对象.

func main() {

var src = []byte(`println("你好,世界")`)

var fset = token.NewFileSet()

var file = fset.AddFile("hello.go", fset.Base(), len(src))

var s scanner.Scanner

s.Init(file, src, nil, scanner.ScanComments)

for {

pos, tok, lit := s.Scan()

if tok == token.EOF {

break

}

fmt.Printf("%s\t%s\t%q\n", fset.Position(pos), tok, lit)

}

}

// output:

// hello.go:1:1 IDENT "println"

// hello.go:1:8 ( ""

// hello.go:1:9 STRING "\"你好,世界\""

// hello.go:1:26 ) ""

// hello.go:1:27 ; "\n"

1.5 Position位置信息

go/token包的Position表示更详细的位置信息,被定义为一个结构体:

type Position struct {

Filename string // filename, if any

Offset int // offset, starting at 0

Line int // line number, starting at 1

Column int // column number, starting at 1 (byte count)

}

Filename表示文件名Offset对应文件内的字节偏移量(从0开始)Line和Column对应行列号(从1开始).比较特殊的是Offset成员,它用于从文件数据定位代码,但是输出时会将偏移量转换为行列号输出.

打印位置信息时,根据文件名、行号和列号有6种组合:

func main() {

a := token.Position{Filename: "hello.go", Line: 1, Column: 2}

b := token.Position{Filename: "hello.go", Line: 1}

c := token.Position{Filename: "hello.go"}

d := token.Position{Line: 1, Column: 2}

e := token.Position{Line: 1}

f := token.Position{Column: 2}

fmt.Println(a.String())

fmt.Println(b.String())

fmt.Println(c.String())

fmt.Println(d.String())

fmt.Println(e.String())

fmt.Println(f.String())

}

// output:

// hello.go:1:2

// hello.go:1

// hello.go

// 1:2

// 1

// -

2. 基础面值

面值是在程序代码中直接表示的值,其它的非零初始值只能由面值常量或常量表达式生成.

比如表达式x+2*y的2就是面值,而x和y则不是面值而是标识符.

2.1 基础面值定义

Go语言规范明确定义了基础面值只有整数、浮点数、复数、符文和字符串几种类型.

需要特别注意的是布尔类型的true和false并不是普通的面值,而是内置的布尔类型标识符(可能被重新定义为其它变量).

在go/token包中,基础面值也被定义为独立的Token:

literal_beg

// Identifiers and basic type literals

// (these tokens stand for classes of literals)

IDENT // main

INT // 12345

FLOAT // 123.45

IMAG // 123.45i

CHAR // 'a'

STRING // "abc"

literal_end

在go/ast分别用两个结构体进行表示基础面值和标识符:

// 基础面值

type BasicLit struct {

ValuePos token.Pos // literal position

Kind token.Token // token.INT, token.FLOAT, token.IMAG, token.CHAR, or token.STRING

Value string // literal string; e.g. 42, 0x7f, 3.14, 1e-9, 2.4i, 'a', '\x7f', "foo" or `\m\n\o`

}

// 标识符

type Ident struct {

NamePos token.Pos // identifier position

Name string // identifier name

Obj *Object // denoted object; or nil

}

整数型面值定义如下:

// 整数型面值分为十进制面值、二进制面值、八进制面值和十六进制面值四种形式. int_lit = decimal_lit | binary_lit | octal_lit | hex_lit . decimal_lit = "0" | ( "1" … "9" ) [ [ "" ] decimal_digits ] . binary_lit = "0" ( "b" | "B" ) [ "" ] binary_digits . octal_lit = "0" [ "o" | "O" ] [ "" ] octal_digits . hex_lit = "0" ( "x" | "X" ) [ "" ] hex_digits .

需要注意的是整数型面值并不支持科学计数法形式,同时数字中间可以添加下划线分隔数字.

浮点数面值定义如下:

// 浮点数面值又分为十进制浮点数和十六进制浮点数. float_lit = decimal_float_lit | hex_float_lit .

// 十进制浮点数 decimal_float_lit = decimal_digits "." [ decimal_digits ] [ decimal_exponent ] | decimal_digits decimal_exponent | "." decimal_digits [ decimal_exponent ] . decimal_exponent = ( "e" | "E" ) [ "+" | "-" ] decimal_digits .

// 十六进制浮点数 hex_float_lit = "0" ( "x" | "X" ) hex_mantissa hex_exponent . hex_mantissa = [ "" ] hex_digits "." [ hex_digits ] | [ "" ] hex_digits | "." hex_digits . hex_exponent = ( "p" | "P" ) [ "+" | "-" ] decimal_digits .

复数面值定义如下:

imaginary_lit = (decimal_digits | int_lit | float_lit) "i" .

符文面值和字符串面值定义如下:

// 符文面值是一个只有一个字符的字符串,由一对单引号包含. rune_lit = "'" ( unicode_value | byte_value ) "'" . unicode_value = unicode_char | little_u_value | big_u_value | escaped_char . byte_value = octal_byte_value | hex_byte_value .

// 字符串由一对双引号或反引号表示,其中可以包含多个字符,但是不能跨行. string_lit = raw_string_lit | interpreted_string_lit . raw_string_lit = "

" { unicode_char | newline } "" . interpreted_string_lit ="{ unicode_value | byte_value }"

- 普通的符文和字符串都可以通过转义字符包含特殊的符号,它们是通过一个特殊的

\斜杠开始.- 反引号表示的字符串表示原生字符串,原生字符串可以跨域多行但是不支持转义字符,因此其内部是无法表示反引号这个字符的.

2.2 基础面值语法树

go/ast包定义了基础面值结构体:

type BasicLit struct {

ValuePos token.Pos // literal position

Kind token.Token // token.INT, token.FLOAT, token.IMAG, token.CHAR, or token.STRING

Value string // literal string; e.g. 42, 0x7f, 3.14, 1e-9, 2.4i, 'a', '\x7f', "foo" or `\m\n\o`

}

ValuePos成员表示该词法元素开始的字节偏移量(并不包含文件名、行号和列号等信息)Kind表示面值的类型(只有数值类型、字符和字符串三类)Value是表示面值的原始代码

2.2.1构造基础面值

package main

import (

"go/ast"

"go/token"

)

func main() {

var lit9527 = &ast.BasicLit{

Kind: token.INT,

Value: "9527",

}

ast.Print(nil, lit9527)

}

// output:

// 0 *ast.BasicLit {

// 1 ValuePos: 1

// 2 Kind: INT

// 3 Value: "9527"

// 4 }

token.INT表示基础面值的类型是整数,值是整数的十进制字符串表示. 如果把token.INT改为token.FLOAT则变成浮点数的9527, 如果改成token.STRING则会变成“9527”字符串面值.

2.2.2 解析基础面值

func main() {

expr, _ := parser.ParseExpr(`9527`)

ast.Print(nil, expr)

}

// output:

// 0 *ast.BasicLit {

// 1 ValuePos: 1

// 2 Kind: INT

// 3 Value: "9527"

// 4 }

基础面值在语法树中是属于叶子结点的存在,在递归遍历语法树时遇到基础面值结点递归就会返回. 同时,通过基础面值、指针、结构体、数组和map等其它语法结构的相互嵌套和组合就可以构造出无穷无尽的复杂类型来.

2.3 标识符面值

go/ast包定义了标识面值结构体:

type Ident struct {

NamePos token.Pos // identifier position

Name string // identifier name

Obj *Object // denoted object; or nil

}

NamePos表示标识符的位置Name是标识符的名字Obj则表示标识符的类型获取其它的扩展信息.作为内置的标识符面值来说,我们主要关注标识符的名字即可.

2.3.1构造标识符面值

package main

import (

"go/ast"

)

func main() {

ast.Print(nil, ast.NewIdent(`x`))

}

// output:

// 0 *ast.Ident {

// 1 NamePos: 0

// 2 Name: "x"

// 3 }

2.2.2 解析基础面值

func main() {

expr, _ := parser.ParseExpr(`x`)

ast.Print(nil, expr)

}

// 从表达式解析标识符,则会通过Obj成员描述标识符额外的信息.

// output:

// 0 *ast.Ident {

// 1 . NamePos: 1

// 2 . Name: "x"

// 3 . Obj: *ast.Object {

// 4 . . Kind: bad

// 5 . . Name: ""

// 6 . }

// 7 }

ast.Object是一个相对复杂的结构,其中Kind用于描述标识符的类型:

const (

Bad ObjKind = iota // for error handling

Pkg // package

Con // constant

Typ // type

Var // variable

Fun // function or method

Lbl // label

)

Bad表示未知的类型,其它的分别对应Go语言中包、常量、类型、变量、函数和标号等语法结构. 而对于标识符中更具体的类型(比如是整数还是布尔类型)则是由

ast.Object的其它成员描述.

3.基础表达式

基础表达式是指完全由数值型面值和标识符组成的表达式.

3.1 基础表达式语法

基础表达式主要是指由一元和二元运算符组成的表达式,运算的主体是各种面值或标识符.

// Expression表示基础表达式的递归定义,可以是UnaryExpr类型的一元表达式,或者是binary_op生成的二元表达式.

// 基础表达式运算符两边的对象由Operand定义,主要是面值或表达式,也可以是由小括弧包含的表达式。

Expression = UnaryExpr | Expression binary_op Expression .

UnaryExpr = Operand | unary_op UnaryExpr .

Operand = Literal | identifier | "(" Expression ")" .

binary_op = "||" | "&&" | rel_op | add_op | mul_op .

rel_op = "==" | "!=" | "<" | "<=" | ">" | ">=" .

add_op = "+" | "-" | "|" | "^" .

mul_op = "*" | "/" | "%" | "<<" | ">>" | "&" | "&^" .

unary_op = "+" | "-" | "!" | "^" | "*" | "&" | "<-" .

3.2 解析表达式